1. C++ 基础

1.1 说一下static关键字的作用

- 全局静态变量

- 在全局变量前加上关键字static,全局变量就定义成一个全局静态变量

- 内存中的位置:静态存储区,在整个程序运行期间一直存在。

- 初始化:未经初始化的全局静态变量会被自动初始化为0(对于自动对象,如果没有显示初始化,会调用零参数构造函数,如不存在则编译失败);

- 作用域:全局静态变量在声明他的文件之外是不可见的,准确地说是从定义之处开始,到文件结尾。

- 局部静态变量

- 在局部变量之前加上关键字

static,局部变量就成为一个局部静态变量。 - 内存中的位置:静态存储区

- 初始化:未经初始化的全局静态变量会被自动初始化为

0(对于自动对象,如果没有显示初始化,会调用零参数构造函数,如不存在则编译失败); - 作用域:作用域仍为局部作用域,

- 当定义它的函数或者语句块结束的时候,作用域结束。

- 但是当局部静态变量离开作用域后,并没有销毁,而是仍然驻留在内存当中,只不过我们不能再对它进行访问,直到该函数再次被调用,并且值不变;

-

C语言中局部静态变量不能使用变量进行初始化的, 因为它在编译期间就被编译器初始化了. -

C++因为引入了对象,必须调用构造函数,所以编译器把对局部静态变量的初始化推迟至第一次调用之前,也就是可以使用变量进行初始化.

- 在局部变量之前加上关键字

- 静态函数

- 在函数返回类型前加static,函数就定义为静态函数。函数的定义和声明在默认情况下都是extern的,但静态函数只是在声明他的文件当中可见,不能被其他文件所用。

- 函数的实现使用static修饰,那么这个函数只可在本cpp内使用,不会同其他cpp中的同名函数引起冲突;

- warning:不要再头文件中声明static的全局函数,不要在cpp内声明非static的全局函数,如果你要在多个cpp中复用该函数,就把它的声明提到头文件里去,否则cpp内部声明需加上static修饰;

- 类的静态成员

- 在类中,静态成员可以实现多个对象之间的数据共享,并且使用静态数据成员还不会破坏隐藏的原则,即保证了安全性。

- 因此,静态成员是类的所有对象中共享的成员,而不是某个对象的成员。对多个对象来说,静态数据成员只存储一处,供所有对象共用

- 类的静态函数

- 静态成员函数和静态数据成员一样,它们都属于类的静态成员,它们都不是对象成员。因此,对静态成员的引用不需要用对象名。

- 在静态成员函数的实现中不能直接引用类中说明的非静态成员,可以引用类中说明的静态成员(这点非常重要)。*如果静态成员函数中要引用非静态成员时,可通过对象来引用。从中可看出,调用静态成员函数使用如下格式:::();*参数表>静态成员函数名>类名>

- 不能被virtual修饰,静态成员函数没有this 指针,虚函数的实现是为每一个对象分配一个vptr 指针,而vptr 是通过this 指针调用的,所以不能为virtual;虚函数的调用关系,this->vptr->ctable->virtual function

1.2 C++和c的区别

- 设计思想上:

-

C++是面向对象(封装, 继承, 多态)的语言,而C是面向过程的结构化编程语言 - C中的函数编译时不会保留形参列表, 也不能重载; 而C++中的函数在编译时会保留形参列表, 有重载

-

- 语法上:

-

C++具有封装、继承和多态三种特性 -

C++相比C,增加许多类型安全的功能,比如强制类型转换、 -

C++支持范式编程,比如模板类、函数模板等

-

- 具体的:

- 动态管理内存的方法不一样:

malloc/free和new/delete - struct

- C中: struct是自定义数据类型; 是变量的集合, 不能添加拥有成员函数; 没有访问权限控制的概念; 结构体名称不能作为参数类型使用, 必须在其前加上struct才能作为参数类型

- C++中: struct是抽象数据类型, 是一个特殊的类, 可以有成员函数, 默认访问权限和继承权限都是public, 结构体名可以作为参数类型使用

- C语言没有引用的概念, 更没有左值引用, 右值引用

- C语言不允许只读数据(const修饰)用作下标定义数组, C++允许

- C语言的局部静态变量初始化发生于编译时,所以在函数中不能使用变量对局部静态变量进行初始化, 而C++因为增加了对象的概念,而对象需要调用构造函数进行初始化,所以编译器将局部静态变量的初始化推迟至该变量使用之前,也就是说可以使用变量来初始化局部静态变量。

- 动态管理内存的方法不一样:

1.3 c++中四种cast转换

C++中四种类型转换是:static_cast,dynamic_cast,const_cast,reinterpret_cast

-

const_cast:- 用来移除

const或volatile属性。但需要特别注意的是const_cast不是用于去除变量的常量性,而是去除指向常数对象的指针或引用的常量性,其去除常量性的对象必须为指针或引用。 - 如果对一个指向常量的指针,通过

const_cast移除const属性, 然后进行修改, 编译通过,但是运行时会报段错误

- 用来移除

-

static_cast: 静态类型转换(不能移除const/volatile属性)是最常看到的类型转换, 几个功能.- 内置类型之间的转换, 精度耗损需要有程序员把握

- 继承体系中的上下行转换(上行:子类转父类,安全转换; 下行:父类转子类, 不安全转换)

-

指针类型转换:

空指针转换成目标类型的空指针,把任何类型转换成void 类型。

-

dynamic_cast: 主要用在继承体系中的安全向下转型- 它能安全地将指向基类的

指针/引用转型为指向子类的指针/引用, 转型失败会返回null(转型对象为指针时)或抛出异常bad_cast(转型对象为引用时)。 -

dynamic_cast会利用运行时的信息(RTTI)来进行动态类型检查,因此dynamic_cast 存在一定的效率损失。 - 而且

dynamic_cast进行动态类型检查时, 利用了虚表中的信息, 所以只能用于函数虚函数的类对象中.

- 它能安全地将指向基类的

-

reinterpret_cast强制类型转换,非常不安全- 它可以把一个指针转换成一个整数,也可以把一个整数转换成一个指针(先把一个指针转换成一个整数,在把该整数转换成原类型的指针,还可以得到原先的指针值)。

1.4 C/C++ 中指针和引用的区别

- 初始化:

- 引用在定义的时候必须进行初始化,并且不能够改变

- 指针在定义的时候不一定要初始化,并且指向的空间可变

- 访问逻辑不同:

- 通过指针访问对象, 用户需要使用间接访问

- 通过引用访问对象, 用户只需使用直接访问, 编译器负责将其处理为间接访问

- 运算结果不同:

- 自增运算结果不同

-

sizeof运算的结果不同 - 下标运算:

- 指针通过下标运算结果是指针所指值为基地址加上偏移, 且基地址可变.

- 引用通过下标运算结果是引用的是数组才能有这个操作.

- 函数参数:

- 传指针的实质是传值,传递的值是指针内储存的变量地址;

- 传引用的实质是传地址,传递的是变量的地址。

- 多级: 有多级指针,但是没有多级引用,只能有一级引用。

- 参考:

1.5 C++中的四个智能指针

- 为什么要使用智慧指针

- 智慧指针的作用是管理指针,因为在堆上申请的内存空间,是需要手动释放的,如果未释放就会造成内存泄漏,而智慧指针的使用可以很大程度的避免这个问题.

- 因为使用智慧指针管理内存的本质是: 栈对象管理堆内存, 而栈对象是超出作用域或者程序意外终止,都会自动调用析构函数,而智慧指针的析构函数会自动释放资源,从而避免内存泄漏.

-

RAII:资源获取就是初始化

-

auto_ptr: 采用所有权模式, 但是其允许所有权剥离,所以有内存崩溃的风险, 在c++11中已经放弃了。 -

unique_ptr:采用独占式拥有,保证同一时间只有一个智慧指针可以指向该对象.unique_ptr不允许所有权剥离,除非本身是临时变量或者使用move指令. -

shared_ptr:采用共享式拥有,多个共享指针可以指向相同的对象,该对象和其相关的资源会在最后一个共享指针被销毁时释放. 注意shared_ptr有交叉引用相互锁死的问题,即两个对象相互持有对方的共享指针, 造成用不释放的问题 -

weak_ptr: 是一种不控制对象生命周期的智慧指针,他是共享指针的附属品, 主要是为了避免shared_ptr的死锁问题,具体表现为weak_ptr只能从shared_ptr或另一个weak_ptr构造,持有它不会造成shared_ptr的引用计数增加,以及并不能通过weak_ptr直接访问推向.

1.6 野指针是什么

- 野指针:指向内存被释放的内存或者没有访问权限的内存的指针。

- “野指针”的成因主要有

3种:-

指针变量没有被初始化。任何指针变量刚被创建时不会自动成为

NULL指针,它的缺省值是随机的。 -

指针被

free或者delete之后,没有置为NULL; - 指针操作超越了变量的作用范围。

-

指针变量没有被初始化。任何指针变量刚被创建时不会自动成为

- 如何避免野指针:

- 对指针进行初始化, 或指向有效地址空间

- 指针用完后释放内存,将指针赋

NULL。char * p = NULL;char * p = (char * )malloc(sizeof(char));char num[ 30] = {0}; char *p = num;delete(p); p = NULL;

1.7 智慧指针内存泄漏的情况

- 当两个对象使用

shared_ptr相互引用,就会使计数器失效,从而导致内存泄漏,解决方案是使用weak_ptr打破循环引用

1.8 什么情况下会发生segmet

- 堆栈溢出

- 非法的数据修改;如static上的数据

- 访问了不存在的内存

- 内存越界,数组越界,变量类型不一致等。 可以使用gdb进行调试修改

1.9 为什么析构函数必须是虚函数? 为什么C++默认的析构函数不是虚函数

- 将可能被继承的基类的析构函数设置为虚函数,可以保证当我们使用基类指针指向派生类对象时,依旧可以正常的

delete, 不至于引起内存泄漏. - 在类中定义虚函数会增加额外的开销,包括虚函数表和虚表指针,对于非基类而言,构造函数如果设置为虚函数会浪费内存.

- 虚函数对应一个虚指针,虚指针其实是存储在对象的内存空间的。如果构造函数是虚的,就需要通过 虚指针执行那个虚函数表(编译期间生成属于类)来调用,可是对象还没有实例化,也就是内存空间还没有,就没有虚指针,所以构造函数不能是虚函数。

- 虚函数的作用在于通过父类的指针或者引用来调用它的时候能够变成调用子类的那个成员函数。而构造函数是在创建对象时自动调用的,不可能通过父类的指针或者引用去调用,因此也就规定构造函数不能是虚函数。

1.10 C++ 中的析构函数的作用

- 析构函数名与类名相同,只是在函数名前增加了取反符号

~以区别于构造函数,其不带任何参数, 也没有返回值. 也不允许重载. - 析构函数与构造函数的相反, 当对象生命周期结束的时候,如对象所在函数被调用完毕时,析构函数负责结束对象的生命周期. 注意如果类对象中分配了堆内存一定要在析构函数中进行释放.

- 和拷贝构造函数类似,如果用户未定义析构函数, 编译器并不是一定会自动合成析构函数, 只有在成员变量或则基类拥有析构函数的情况下它才会自动合成析构函数.

- 如果成员变量或则基类拥有析构函数, 则编译器一定会合成析构函数, 负责调用成员变量或则基类的析构函数, 此时如果用户提供了析构函数,则编译器会在用户析构函数之后添加上述代码.

- 类析构的顺序为: 派生类析构函数, 对象成员析构函数, 基类析构函数.

1.11 C++中自动添加构造函数的情况

- 包含有带默认构造函数的对象成员的类(某成员变量为带默认构造函数的类的对象):

- 若一个类X没有定义任何构造函数,但却包含一个或以上定义有默认构造函数的对象成员,此时编译器会为X合成默认构造函数,该默认函数会调用对象成员的默认构造函数为之初始化。

- 如果对象的成员没有定义默认构造函数,那么编译器合成的默认构造函数将不会为之提供初始化。

- 继承自带有默认构造函数的基类的类(基类带有默认构造函数)

- 带有虚函数(来自声明或继承):因为它多了一个vptr,而vptr的设置是由编译器完成的,因此编译器会为类的每个构造函数添加代码来完成对vptr的初始化。*

- 带有一个虚基类的类:在这种情况下,编译器要将虚基类在类中的位置准备妥当,提供支持虚基类的机制。也就是说要在所有构造函数中加入实现前述功能的的代码。没有构造函数将合成默认构造函数。

1.12 编译器合成拷贝构造函数的情况

- 编译器在必要的时候会合成拷贝构造函数:必要的时刻是指编译器在普通手段无法完成解决“当一个类对象以另一个同类实体作为初值”时,才会合成拷贝构造函数。也就是说,当常规武器能解决问题的时候,就没必要动用非常规武器。

- 如果一个类没有定义拷贝构造函数,通常按照“成员逐一初始化(Default Memberwise Initialization)”的手法来解决“一个类对象以另一个同类实体作为初值”.

- 成员逐一初始化(Default Memberwise Initialization)具体的实现方式则是位逐次拷贝(Bitwise copy semantics)[^6]。[^6]: Bitwise copy semantics 是Default Memberwise Intializiation的具体实现方式。[别人的解释]

下面是没有定义时默认合成的情况:

- 类内含一个声明有拷贝构造函数成员对象(不论是设计者定义的还是编译器合成的)。

- 类继承自一个声明有拷贝构造函数的类(不论拷贝构造函数是被显示声明还是由编译器合成的)。

- 类中声明有虚函数。

- 当类的派生串链中包含有一个或多个虚基类。

1.13 重载和覆盖

- C++中重载、重写(覆盖)和隐藏的区别

- 重载: 同一可访问区域内声明了多个具有不同参数列表的同名函数, 根据参数列表确定那个函数被调用, 重载不关心函数返回类型.

-

覆盖/重写: 是指派生类中重新定义了基类中的

virtual函数. 其函数名,参数列表,返回值类型,所有都与基类中被重写的函数一致。派生类对象通过派生类指针或则基类指针调用时都会调用派生类的重写函数。 - 隐藏:是指派生类的函数屏蔽了与其同名的基类函数,只要函数名相同,基类函数都会被隐藏. 不管参数列表是否相同。

- 重载和重写的区别:

1) 范围区别:重写和被重写的函数在不同的类中,重载和被重载的函数在同一类中。

2) 参数区别:重写与被重写的函数参数列表一定相同,重载和被重载的函数参数列表一定不同。

3)

virtual区别:重写的基类必须要有virtual修饰,重载函数和被重载函数可以被virtual修饰,也可以没有。 - 隐藏和重写,重载的区别: 1) 与重载范围不同:隐藏函数和被隐藏函数在不同类中。 2) 参数的区别:隐藏函数和被隐藏函数参数列表可以相同,也可以不同,但函数名一定同;

1.14 在main()之前执行前运行

- 使用

staticlambda函数://关闭流输出 static auto static_lambda = []() { std::ios::sync_with_stdio(false); std::cin.tie(0); return 0; }(); -

GCC编译器// 在main之前 __attribute((constructor)) void before_main(){ printf("befor\n"); } // 在main之后 __attribute((deconstructor)) void after_main(){ printf("befor\n"); }

1.15 字面值常量和左右值

- 简述四行代码的区别

const char* arr = "123"; // "123" 为字符串类型字面值, 其储存于常量区, 其值不可修改, arr表示一个指向字符串类型的const指针, 如果试图通过此指针修改字符串的指,编译器会组织这一行为,导致编译失败 char * brr = "123"; // "123" 为字符串类型字面值, 其储存于常量区, 其值不可修改, brr表示一个指向字符串类型的指针, 这里潜在的逻辑错误, 当我们试图通过brr修改所指向的字符串时, 编译器并不会阻止这一行为, 可编译通过, 但是运行时候,可能发生 DEADLYSIGNAL(致命错误) const char crr[] = "123" // 声明了一个以"123"为初值的常量数组, 通常情况下应该是存在于栈区, 但是使用了const修饰,编译器可能会将其放在常量区 char drr[] = "123"; // 声明了一个以"123"为初值的字符串数组, 应该是储存于栈区, 可通过drr对数组进行修改

- C/C++的四大内存分区和常量的存储位置

-

std::forward的作用: C++完美转发为什么必须要有std::forward - 左值右值的区别: C++中的左值与右值(二)

1.16 C++如何处理返回值

-

函数的返回值用于初始化在调用函数时创建的临时对象: 1) 返回值为非引用类型:会将函数的返回值复制给临时对象。 2) 返回值为引用类型:没有复制返回值,返回的是对象本身。(但是不能返回局部变量的引用, 可以是主函数以引用方式传递的对象,或则是堆对象的引用-堆对象的引用可能会造成内存溢出)

-

关于返回值:

- 如果

返回值 <= 4字节,则返回值通过寄存器eax带回。 - 如果

4< 返回值 <=8字节,则返回值通过两个寄存器eax和edx带回。 - 如果

返回值 > 8字节,则返回值通过产生的临时量带回。

- 如果

1.17 const?

- 一般可以分为如下六种类型

-

const变量(const int *p1): 表明标了为const类型, 通常需要被初始化否则后面将不能被修改, 对该变量的修改操作都会被编译器阻止.(起始就是top-level const) -

const指针对象(int * const p2): 标明该指针为普通的左值类型可以进行修改, 但是不能通过该变量修改做指向的对象, 则通过该指针只能访问const类型的成员函数.(bottom-level const) -

const引用: 它所绑定的对象不能被修改 -

const形参: 和普通的实参分类一样分为const 变量, const指针对象, const 引用, 作用也类似,表示不能修改该变量. -

const返回值: 通常是为了表明返回值是一个const类型防止返回值被修改, 或则被当做左值放在赋值运算的左边 -

const成员函数: 是指成员函数不会修改类对象的任何成员变量, 如果返回值为对象成员的引用则必须返回const引用, 同时const成员函数不能调用非const函数, 其主要是因为const成员函数所持有的this指针是一个const类型的指针, 因为不能调用非const类型的成员函数.

-

- const顶层指针和底层指针:

-

(常指针对象)

int *const p2中const修饰p2的值,所以理解为p2的值不可以改变,即p2只能指向固定的一个变量地址,但可以通过*p2 -

(常指针)

int const *p1或者const int *p1两种情况中const修饰*p1,所以理解为*p1的值不可以改变,即不可以给*p1赋值改变p1指向变量的值,但可以通过给p赋值不同的地址改变这个指针指向。底层指针表示指针所指向的变量是一个常量。 ***

-

(常指针对象)

- 参考: c++函数返回类型什么情况带const - A_zhu - 博客园

1.18 C 语言struct 和C++ struct 区别

-

struct在C语言中:- 是用户自定义数据类型

(UDT); - 只能是一些变量的集合体, 成员不能为函数

- 没有权限设置

- 一个结构标记声明后,在

C中必须在结构标记前加上struct,才能做结构类型名;

- 是用户自定义数据类型

-

struct在C++中:- 是抽象数据类型

(ADT),支持成员函数的定义,(能继承,能实现多态)。 - 增加了访问权限, 默认访问限定符为

public(为了与C兼容),class中的默认访问限定符为private - 定义完成之后, 可以直接使用结构体名字作为结构类型名

- 可以使用模板

- 是抽象数据类型

1.19 类成员的构造函数

一个派生类构造函数的执行顺序如下: - 虚基类的构造函数(多个虚拟基类则按照继承的顺序执行构造函数)。 - 基类的构造函数(多个普通基类也按照继承的顺序执行构造函数)。 - 类类型的成员对象的构造函数(按照初始化顺序) - 派生类自己的构造函数。

- 对于类对象类型成员变量, 则是先调用零参数构造函数, 如果零参数构造函数不存在编译器将会报错.

1.20 构造函数, 析构函数可否抛出异常

- 构造函数异常

- 后果:

-

(原因):

C++拒绝为没有完成构造函数的对象调用析构函数,原因是避免开销 - 构造函数中发生异常,控制权转出构造函数。如果构造函数中申请了堆内存, 则堆内存将无法释放, 从而造成内存泄漏

- 例如: 在对象

b的构造函数中发生异常,对象b的析构函数不会被调用。因此会造成内存泄漏。

-

(原因):

- 解决方案:

- 使用智慧指针来管理堆内存. 其不需要在析构函数中手动释放资源. 在发生异常时, 智慧指针会自动释放资源从而避免了内存泄漏.

- 一般建议不要在构造函数里做过多的资源分配。

- 后果:

- 析构函数异常

- 后果:

- 在异常传递的堆栈辗转开解的过程中, 如果发生析构异常,

C++会调用terminate终止程序 - 如果析构函数发生发生异常,则异常后面的代码将不执行,无法确保完成我们想做的清理工作。

- 在异常传递的堆栈辗转开解的过程中, 如果发生析构异常,

- 解决方法:

- 如果异常不可避免,则应在析构函数内捕获,而不应当抛出。

- 在析构函数中使用

try-catch块屏蔽所有异常。

- 附加说明:

- (后果1): 如果某一个异常发生,某对象的析构函数被调用,而此时析构发生了异常并流出了函数之外,则函数会被立即terminate掉(函数外有catch也不能拯救)

- 后果:

1.21、什么是类的继承?

- 类与类之间的关系

-

(has-A)包含关系,即一个类的成员属性是另一个已经定义好的类 -

(use-A)使用关系, 一个类使用另一个类,通过类之间的成员函数相互联系,定义友元或者通过传递参数的方式实现; -

(is-A)继承关系, 继承关系,关系具有传递性;

-

- 继承的相关概念

- 所谓的继承就是一个类继承了另一个类的属性和方法,这个新的类包含了上一个类的属性和方法,

- 被称为子类或者派生类,被继承的类称为父类或者基类;

- 继承的特点

- 子类拥有父类的所有属性和方法,子类对象可以当做父类对象使用;

- 子类可以拥有父类没有的属性和方法;

- 继承中的访问控制

-

public、protected、private

-

- 继承中的构造和析构函数

- 子类中构造函数的调用顺序为: 基类构造函数, 成员对象构造函数, 派生类构造函数

- 子类中析构函数的调用顺序为: 派生类析构函数, 成员对象析构函数, 基类析构函数

- 继承中的兼容性原则

- 类型兼容规则是指在需要基类对象的任何地方,都可以使用公有派生类的对象来替代。

- 参考: 继承中的类型兼容性原则 - Say舞步 - 博客园

1.22 什么是组合?

- 一个类里面的数据成员是另一个类的对象,即内嵌其他类的对象作为自己的成员;

- 如果内嵌类没有零参数构造函数, 则必须使用初始化列表进行初始化

- 构造函数的执行顺序:

- 按照内嵌对象成员在组合类中的定义顺序调用内嵌对象的构造函数。

- 然后执行组合类构造函数的函数体,析构函数调用顺序相反。

1.23 C 语言的编译链接过程?

- 源代码-->预处理-->编译-->优化-->汇编-->链接–>可执行文件

- 参考: 源码到可执行文件的过程

1.24 说说你对c 和c++的看法,c 和c++的区别?

- 面向过程 / 面向对象

- C中的函数编译时不会保留形参列表, 也不能重载; 而C++中的函数在编译时会保留形参列表, 有重载

- struct

- C中: struct是自定义数据类型; 是变量的集合, 不能添加拥有成员函数; 没有访问权限控制的概念; 结构体名称不能作为参数类型使用, 必须在其前加上struct才能作为参数类型

- C++中: struct是抽象数据类型, 是一个特殊的类, 可以有成员函数, 默认访问权限和继承权限都是public, 结构体名可以作为参数类型使用

- 动态管理内存的方法不一样:

malloc/free和new/delete - C语言没有引用的概念, 更没有左值引用, 右值引用

- C语言不允许只读数据(const修饰)用作下标定义数组, C++允许

- C语言的局部静态变量初始化发生于编译时,所以在函数中不能使用变量对局部静态变量进行初始化, 而C++因为增加了对象的概念,而对象需要调用构造函数进行初始化,所以编译器将局部静态变量的初始化推迟至该变量使用之前,也就是说可以使用变量来初始化局部静态变量。

- C++相比C,增加多许多类型安全的功能,比如强制类型转换

- C++支持范式编程,比如模板类、函数模板等

-

PS:C/C++的全局变量默认连接属性都是extern的啊, 参考:C语言:链接属性与存储类型 - 参考:

1.25 new和delete的实现原理,delete是如何知道释放内存的大小的额?

-

new- 简单类型直接调用

operator new分配内存; - 对于复杂结构,先调用

operator new分配内存,然后在分配的内存上调用构造函数;

- 简单类型直接调用

-

delete- 简单数据类型默认只是调用

free函数; - 复杂数据类型先调用析构函数再调用

operator delete;

- 简单数据类型默认只是调用

-

new[]- 对于简单类型,

new[]计算好大小后调用operator new; - 对于复杂数据结构

AA* P = new AA[10];-

new[]先调用operator new[]分配内存, 分配内存时多分配四个字节用于存放元素个数., 返回地址为p -

p的最开始的4个字节用于存放元素个数n, 然后从调用n次构造函数从p-4开始构造对象. - 返回地址,也就是

P, 即为p-4

- 对于简单类型,

-

delete[]- 对于简单类型, 直接调用

free进行释放(注意简单类型并没有利用4个字节保存元素个数, 由编译器自行优化) - 对于复制类型,

- 首先将指针前移

4个字节获得元素个数n, 然后执行n次析构函数, 最后并释放掉内存. - 因为指针指向的是

p-4并不是内存的起始地址, 所以使用delete将无法完成释放, 因为free需要通过起始地址进行释放, 而p-4不是起始地址

- 首先将指针前移

- 对于简单类型, 直接调用

- 参考: 一定要看看:深入理解C++ new/delete, new/delete 动态内存管理

1.26 内存对齐?位域?

- 字节对齐的原因:

- 更快: 如果数据未对齐自然边界, 则处理器需要两次寻址才能得到完整的数据

- 通用: 部分硬件平面不支持访问未对齐的数据, 会抛出硬件异常

- 具体操作

- 自定义对齐系数

- 可以通过预编译命令

#pragma pack(n),n=1,2,4,8,16来改变这一系数,其中的n就是指定的“对齐系数”

- 可以通过预编译命令

- 数据成员对齐规则:

- 结构

(struct)(或联合(union))的数据成员,第一个数据成员放在offset为0的地方,以后每个数据成员的对齐按照#pragma pack指定的数值和这个数据成员自身长度中,比较小的那个进行。 - 结构体作为成员:

- 如果一个结构里有某些结构体成员,则结构体成员要从其内部最大元素大小的整数倍地址开始存储。

- 结构

- 结构(或联合)的整体对齐规则:

- 在数据成员完成各自对齐之后,结构(或联合)本身也要进行对齐,对齐将按照

#pragma pack指定的数值和结构(或联合)最大数据成员长度中,比较小的那个进行。

- 在数据成员完成各自对齐之后,结构(或联合)本身也要进行对齐,对齐将按照

- 自定义对齐系数

- 位域

- 有些信息在存储时,并不需要占用一个完整的字节, 而只需占几个或一个二进制位。

-

C语言又提供了一种数据结构,称为“位域”或“位段”。 - 所谓“位域”是把一个字节中的二进位划分为几 个不同的区域,并说明每个区域的位数。

- 位段成员必须声明为

int、unsigned int或signed int类型(short char long)。 ```c struct 位域结构名{ 位域列表 // 其中位域列表的形式为: 类型说明符 位域名:位域长度 };

struct bs {

int a:8; int b:2; int c:6; };

```

1.27 hello world 程序开始到打印到屏幕上的全过程?

- 应用程序

- 应用程序载入内存变成进程

- 进程获取系统的标准输出接口

- 系统为进程分配CPU

- 触发缺页中断

- 通过puts系统调用, 往标准输出接口上写字符串

- 操作系统将字符串发送到显示器驱动上

- 驱动判断该操作的合法性, 然后将该操作变成像素, 写入到显示器的储存映射区

- 硬件将该像素值改变转变成控制信号控制显示器显示

- 用户告诉操作系统执行

HelloWorld程序(通过键盘输入等) - 操作系统:找到

helloworld程序的相关信息,检查其类型是否是可执行文件;并通过程序首部信息,确定代码和数据在可执行文件中的位置并计算出对应的磁盘块地址。 - 操作系统:创建一个新进程,将

HelloWorld可执行文件映射到该进程结构,表示由该进程执行helloworld程序。 - 操作系统:为

helloworld程序设置cpu上下文环境,并跳到程序开始处。 - 执行

helloworld程序的第一条指令,发生缺页异常 - 操作系统:分配一页物理内存,并将代码从磁盘读入内存,然后继续执行

helloworld程序 -

helloword程序执行puts函数(系统调用),在显示器上写一字符串 - 操作系统:找到要将字符串送往的显示设备,通常设备是由一个进程控制的,所以,操作系统将要写的字符串送给该进程

- 操作系统:控制设备的进程告诉设备的窗口系统,它要显示该字符串,窗口系统确定这是一个合法的操作,然后将字符串转换成像素,将像素写入设备的存储映像区

- 视频硬件将像素转换成显示器可接收和一组控制数据信号

- 显示器解释信号,激发液晶屏

-

OK,我们在屏幕上看到了HelloWorld

1.28 全局变量和static 变量的区别

- static变量分为两个类型: 全局静态变量(在全局变量的类型前加上static)和局部静态变量(在局部变量的类型前加上static).

- 从储存形式看: 他们没有区别, 都储存于静态数据区

- 从作用域看:

- 全局变量默认具有extern属性, 它的作用域为整个项目, 可能和其他cpp文件中的全局变量发生命名冲突.

- 全局静态变量,作用域受限, 它的作用域仅限于定义它的文件内有效, 不会和其他cpp文件中的全局变量发生命名冲突.

- 局部静态变量, 作用域依旧不管, 当时当离开作用域时不会变量不会被释放, 其值保持不变只是被屏蔽了, 直到再次进入作用域, 其也只会被初始化一次.

1.29 何时需要成员初始化列表?过程是什么?

- 需要成员初始化列表:

- 引用类型的成员变量

- const类型的成员变量

- 基类不存在零参数构造函数

- 成员对象不存在零参数构造函数

- 过程:

- 编译器会根据成员变量定义顺序一一初始化成员变量, 如果相应成员在成员初始化列表中有初始化参数, 则用成员初始化列表中的参数进行构造

- 发生在用户自定义代码段之前.

1.30 成员函数里

memset(this,0,sizeof(*this))会发生什么1) 如果类中的所有成员都是内置的数据类型的, 则不会存在问题 2) 如果有以下情况之一会出现问题:

- 存在对象成员

- 存在虚函数/虚基类

- 如果在构造函数中分配了堆内存, 而此操作可能会产生内存泄漏

1.31 方法调用的原理(栈,汇编)

- 每一个函数都对应一个栈帧:

- 帧栈可以认为是程序栈的一段

- 它有两个端点

- 一个标识起始地址, 开始地址指针ebp;

- 一个标识着结束地址,结束地址指针esp;

- 函数调用使用的参数, 返回地址等都是通过栈来传递的.

- 函数调用过程:

- 参数逆序入栈(主调函数)

- 返回值地址入栈(主调函数)(被调函数栈底往上4个子节为返回地址)

- 主调函数栈底入栈(被调函数)

- 栈顶给栈底赋值(被调函数)

-

被调函数局部变量…

- 被调函数局部变量析构

- 恢复主调函数栈帧

- 获取返回地址, 继续执行主调函数代码

- 关于返回值:

- 如果

返回值 <= 4字节,则返回值通过寄存器eax带回。 - 如果

4< 返回值 <=8字节,则返回值通过两个寄存器eax和edx带回。 - 如果

返回值 > 8字节,则返回值通过产生的临时量带回。

- 如果

1.32 C++11中的可变参数模板、右值引用和lambda

- 可变参数模板:

-

C++11的可变参数模板,对参数进行了高度泛化,可以表示任意数目、任意类型的参数 - 其语法为:在

class或typename后面带上省略号。 - 例如:

Template<class ... T> void func(T ... args){ cout<<”num is”<<sizeof ...(args)<<endl; } func();//args不含任何参数 func(1);//args包含一个int类型的实参 func(1,2.0)//args包含一个int一个double类型的实参 - 其中

T叫做模板参数包,args叫做函数参数包 - 省略号作用如下:

- 声明一个包含

0到任意个模板参数的参数包 - 在模板定义得右边,可以将参数包展成一个个独立的参数

- 声明一个包含

-

C++11可以使用递归函数的方式展开参数包,获得可变参数的每个值。通过递归函数展开参数包,需要提供一个参数包展开的函数和一个递归终止函数。 - 例如:

#include using namespace std; // 最终递归函数 void print(){ cout << "empty" << endl; } // 展开函数 template void print(T head, Args... args){ cout << head << ","; print(args...); } int main(){ print(1, 2, 3, 4); return 0; } - 参数包

Args ...在展开的过程中递归调用自己,没调用一次参数包中的参数就会少一个,直到所有参数都展开为止。当没有参数时就会调用非模板函数printf终止递归过程。

-

- 右值引用:

-

C++中,左值通常指可以取地址,有名字的值就是左值,而不能取地址,没有名字的就是右值。 - 而在

C++11中,右值是由两个概念构成,将亡值和纯右值。纯右值是用于识别临时变量和一些不跟对象关联的值,比如1+3产生的临时变量值2,true等,而将亡值通常是指具有转移语义的对象,比如返回右值引用T&&的函数返回值等。 -

C++11中,右值引用就是对一个右值进行引用的类型。 - 由于右值通常不具有名字,所以我们一般只能通过右值表达式获得其引用

- 比如:

T && a=ReturnRvale();- 假设

ReturnRvalue()函数返回一个右值,那么上述语句声明了一个名为a的右值引用,其值等于ReturnRvalue函数返回的临时变量的值。

- 基于右值引用可以实现转移语义和完美转发新特性。

-

- 移动语义:

- 对于一个包含指针成员变量的类,由于编译器默认的拷贝构造函数都是浅拷贝,所有我们一般需要通过实现深拷贝的拷贝构造函数,为指针成员分配新的内存并进行内容拷贝,从而避免悬挂指针的问题。

- 如下列代码所示:

#include<iostream> using namespace std; class HasPtrMem{ public: HasPtrMem(): d(new int(0)){ cout << "Construct: " << ++n_cstr <<endl; } HasPtrMem(const HasPtrMem &h): d(new int(*h.d)){ cout << "Copy construct: " << ++n_cptr << endl; } ~HasPtrMem(){ cout << "Destruct: " << ++n_dstr << endl; } int *d; static int n_cstr; static int n_dstr; static int n_cptr; }; int HasPtrMem::n_cstr = 0; int HasPtrMem::n_dstr = 0; int HasPtrMem::n_cptr = 0; HasPtrMem GetTemp(){return HasPtrMem();} int main(){ HasPtrMem a = GetTemp(); } - 当类

HasPtrMem包含一个成员函数GetTemp,其返回值类型是HasPtrMem,如果我们定义了深拷贝的拷贝构造函数,那么在调用该函数时需要调用两次拷贝构造函数。第一次是生成GetTemp函数返回时的临时变量,第二次是将该返回值赋值给main函数中的变量a。与此对应需要调用三次析构函数来释放内存。 - 而在上述过程中,使用临时变量构造

a时会调用拷贝构造函数分配对内存,而临时对象在语句结束后会释放它所使用的堆内存。这样重复申请和释放内存,在申请内存较大时会严重影响性能。因此C++使用移动构造函数,从而保证使用临时对象构造a时不分配内存,从而提高性能。 - 如下列代码所示,移动构造函数接收一个右值引用作为参数,使用右值引用的参数初始化其指针成员变量。

HasPtrMem(HasPtrMem &&h): d(h.d){ // 移动构造函数 h.d = nullptr; // 将临时值得指针成员置空 cout << "Move construct: " << ++n_mvtr << endl; } - 其原理就是使用在构造对象

a时,使用h.d来初始化a,然后将临时对象h的成员变量d指向nullptr,从而保证临时变量析构时不会释放对内存。

- 完美转发:

- 完美转发是指在函数模板中,完全依照模板的参数的类型,将参数传递给函数模板中调用的另一个函数,即传入转发函数的是左值对象,目标函数就能获得左值对象,转发函数是右值对象,目标函数就能获得右值对象,而不产生额外的开销。

- 因此转发函数和目标函数参数一般采用引用类型,从而避免拷贝的开销。其次,由于目标函数可能需要能够既接受左值引用,又接受右值引用,所以考虑转发也需要兼容这两种类型。

-

C++11采用引用折叠的规则,结合新的模板推导规则实现完美转发。其引用折叠规则如下: - 参考: 什么是右值引用,跟左值又有什么区别?

TR类型定义 声明v的类型 v的实际类型 T& TR A& T& TR& A& T& TR&& A& T&& TR A&& T&& TR& A& T&& TR&& A&& - 因此,我们将转发函数和目标函数的参数都设置为右值引用类型

void IamForwording(T && t){ IrunCodeActually(static_cast<T &&>(t)); } - 当传入一个X类型的左值引用时,转发函数将被实例为:

void IamForwording(X & && t){ IrunCodeActually(static_cast<T& &&>(t)); } - 经过引用折叠,变为:

void IamForwording(X & t){ IrunCodeActually(static_cast<X &>(t)); } - 当传入一个X类型的右值引用时,转发函数将被实例为:

void IamForwording(X&& && t){ IrunCodeActually(static_cast<X && &&>(t)); } - 经过引用折叠,变为:

void IamForwording(X&& t){ IrunCodeActually(static_cast<X &&>(t)); } - 除此之外,还可以使用

forward()函数来完成左值引用到右值引用的转换:template <typename T> void IamForwording(T && t){ IrunCodeActually(forward(t)); }

-

Lambda表达式: -

Lambda表达式定义一个匿名函数,并且可以捕获一定范围内的变量 - 其定义如下:

[capture](params)mutable->return-type{statement}- 其中:

-

[capture]:捕获列表,捕获上下文变量以供lambda使用。同时[]是lambda寅初复,编译器根据该符号来判断接下来代码是否是lambda函数。 -

(Params):参数列表,与普通函数的参数列表一致,如果不需要传递参数,则可以连通括号一起省略。 -

mutable是修饰符,默认情况下lambda函数总是一个const函数,Mutable可以取消其常量性。在使用该修饰符时,参数列表不可省略。 -

->return-type:返回类型是返回值类型 -

{statement}:函数体,内容与普通函数一样,除了可以使用参数之外,还可以使用所捕获的变量。 -

Lambda表达式与普通函数最大的区别就是其可以通过捕获列表访问一些上下文中的数据。其形式如下:-

[val]表示值传递方式捕捉变量var -

[=]表示值传递方式捕捉所有父作用域的变量(包括this) -

[&val]表示引用传递捕捉变量var -

[this]表示值传递方式捕捉当前的this指针

-

-

-

Lambda的类型被定义为“闭包”的类,其通常用于STL库中,在某些场景下可用于简化仿函数的使用,同时Lambda作为局部函数,也会提高复杂代码的开发加速,轻松在函数内重用代码,无须费心设计接口。

1.33 C++ 如何管理内存

- Linux的进程内存分配

- 栈上的内存由编译器管和操作系统管理,基本不用关心

- c++设置了对象的构造函数和析构函数,实现类的生命周期的管理。

- 对于堆上的内存管理,c++主要由new和delect。

- c++为了更好的管理内存,提供了智能指针,帮助管理内存。避免了内存的手动释放的复杂性。

1.34 C++11/17的新特性

- Lambda表达式,多用于STL

- 智能指针

- 新的多线程库,

- auto关键字:注意:auto 变量必须在定义时初始化,这类似于const关键字;定义在一个auto序列的变量必须始终推导成同一类型。

- 如果初始化表达式是引用,则去除引用语义。

- 如果初始化表达式为const或volatile(或者两者兼有),则除去const/volatile语义。

- 函数或者模板参数不能被声明为auto

1.35 include 包含文件的时候,尖括号和双引号有什么区别

-

双引号是优先在工程文件makefile标识的文件夹中寻找,找不到再去库文件夹中找

-

系统自带的头文件用尖括号,会在系统文件目录下查找

- 用户自定义文件用双引号,编译器首先在用户目录下查找,然后到c++安装目录中查找,最后在系统文件查找

1.36 inline 关键字总结

- 使用inline关键字的函数可能会被编译器忽略而不在调用处展开,如虚函数。

- 如果定义的inline函数过大,为了防止生成的obj文件太大,编译器会忽略这里的inline声明

- inline是在编译器将函数类容替换到函数调用处,是静态编译的。而虚函数是动态调用的,在编译器并不知道需要调用的是父类还是子类的虚函数,所以不能够inline声明展开,所以编译器会忽略

- 头文件中不仅要包含inline函数的声明,还要包含inline函数的定义

- 编译器需要把inline函数体替换到函数调用处,所以编译器必须要知道inline函数的函数体是啥,所以要将inline函数的函数定义和函数声明一起写在头文件中,便与编译器查找替换。

- 可以在同一个项目的不同源文件内定义函数名相同,实现相同的inline函数

- 同一个inline函数可以多处声明和定义,但是必须要完全相同

- 定义在class声明内的成员函数默认是inline函数

- 类的构造函数不能是虚函数

- 构造函数是为了构造对象的,所以在调用构造函数时候必然知道是哪个对象调用了构造函数,所以构造函数不能为虚函数。

- 类的静态成员函数不能是虚函数

- 类的静态成员函数是该类共用的,与该类的对象无关,静态函数里没有this指针,所以不能为虚函数。

1.37 说一个malloc底层和memset;

-

结论:

- 当开辟的空间小于 128K 时,调用 brk()函数,malloc 的底层实现是系统调用函数 brk(),其主要移动指针 _enddata(此时的 _enddata 指的是 Linux 地址空间中堆段的末尾地址,不是数据段的末尾地址)

- 当开辟的空间大于 128K 时,mmap()系统调用函数来在虚拟地址空间中(堆和栈中间,称为“文件映射区域”的地方)找一块空间来开辟。

- brk分配的内存需要等到高地址内存释放以后才能释放(例如,在B释放之前,A是不可能释放的,因为只有一个_edata 指针,这就是内存碎片产生的原因,什么时候紧缩看下面),而mmap分配的内存可以单独释放。因此对于大内存需要使用mmap防止产生更多的内存碎片

-

系统调用过程

-

检查要访问的虚拟地址是否合法:

-

在linux系统下面一个程序的堆的管理是通过内存块进行管理的,也就是将堆分成了很多大小不一的内存块。

/**内存控制块数据结构,用于管理所有的内存块 * is_available: 标志着该块是否可用。1表示可用,0表示不可用 * size: 该块的大小 **/ struct mem_control_block { int is_available; int size; };

-

-

查找/分配一个物理页

-

填充物理页内容(读取磁盘,或者直接置0,或者什么都不做)

-

建立映射关系(虚拟地址到物理地址的映射关系)

-

重复执行发生缺页中断的那条指令

-

注意:如果第3步,需要读取磁盘,那么这次缺页就是 majfit(major fault:大错误),否则就是 minflt(minor fault:小错误)

-

下面是分别执行

A=malloc(30K),B=malloc(40K),C=malloc(200K),D=malloc(100K); -

-

-

free:

- 进程调用free(C)以后,C对应的虚拟内存和物理内存一起释放.

- 进程调用free(B)以后,如图7所示;B对应的虚拟内存和物理内存都没有释放,因为只有一个_edata指针,如果往回推,那么D这块内存怎么办呢?当然,B这块内存,是可以重用的,如果这个时候再来一个40K的请求,那么malloc很可能就把B这块内存返回回去了

- 进程调用free(D)以后,如图8所示:B和D连接起来,变成一块140K的空闲内存

- 默认情况下:当最高地址空间的空闲内存超过128K(可由M_TRIM_THRESHOLD选项调节)时,执行内存紧缩操作(trim)。在上一个步骤free的时候,发现最高地址空闲内存超过128K,于是内存紧缩,变成图9所示

-

因为memset是按照字节进行操作的。因此注意设置的值需要从重复的char转换为int。

-

注意:memcopy和memmove 需要考虑内存重叠,发现重叠时,需要从尾部到头部进行拷贝。

1.38 Player a;Player b = a;Player c; c = a;区别

初始化的=调用的是默认拷贝构造函数,初始化后的=调用的是重载的=符号函数。

1.39 说一下C++中的this指针

- 一个对象的this指针并不是对象本身的一部分,不会影响sizeof(对象)的结果。this作用域是在类内部,当在类的非静态成员函数中访问类的非静态成员的时候,编译器会自动将对象本身的地址作为一个隐含参数传递给函数。也就是说,即使你没有写上this指针,编译器在编译的时候也是加上this的,它作为非静态成员函数的隐含形参,对各成员的访问均通过this进行。 例如,调用date.SetMonth(9) <===> SetMonth(&date, 9),this帮助完成了这一转换 .

- 调用成员函数时,常常使用ecx寄存器传递this参数。

- this在成员函数的开始前构造,在成员函数的结束后清除。

-

几个this指针的易混问题

-

A. this指针是什么时候创建的?

- this在成员函数的开始执行前构造,在成员的执行结束后清除。

- 但是如果class或者struct里面没有方法的话,它们是没有构造函数的,只能当做C的struct使用。采用 TYPE xx的方式定义的话,在栈里分配内存,这时候this指针的值就是这块内存的地址。采用new的方式创建对象的话,在堆里分配内存,new操作符通过eax返回分配的地址,然后设置给指针变量。之后去调用构造函数(如果有构造函数的话),这时将这个内存块的地址传给ecx,之后构造函数里面怎么处理请看上面的回答。

-

B. this指针存放在何处?堆、栈、全局变量,还是其他?

- this指针会因编译器不同而有不同的放置位置。可能是栈,也可能是寄存器,甚至全局变量。在汇编级别里面,一个值只会以3种形式出现:立即数、寄存器值和内存变量值。不是存放在寄存器就是存放在内存中,它们并不是和高级语言变量对应的。

-

C. this指针是如何传递类中的函数的?绑定?还是在函数参数的首参数就是this指针?那么,this指针又是如何找到“类实例后函数的”?

- 大多数编译器通过ecx寄存器传递this指针。事实上,这也是一个潜规则。一般来说,不同编译器都会遵从一致的传参规则,否则不同编译器产生的obj就无法匹配了。

- 在call之前,编译器会把对应的对象地址放到eax中。this是通过函数参数的首参来传递的。this指针在调用之前生成,至于“类实例后函数”,没有这个说法。类在实例化时,只分配类中的变量空间,并没有为函数分配空间。自从类的函数定义完成后,它就在那儿,不会跑的。

-

D. this指针是如何访问类中的变量的?

- 如果不是类,而是结构体的话,那么,如何通过结构指针来访问结构中的变量呢?如果你明白这一点的话,就很容易理解这个问题了。

- 在C++中 ,类和结构是只有一个区别的:类的成员默认是private,而结构是public**。

- this是类的指针,如果换成结构,那this**就是结构的指针了。

-

E. 我们只有获得一个对象后,才能通过对象使用this指针。如果我们知道一个对象this指针的位置,可以直接使用吗?

- this指针只有在成员函数中才有定义。因此,你获得一个对象后,也不能通过对象使用this指针。所以,我们无法知道一个对象的this指针的位置(只有在成员函数里才有this指针的位置)。当然,在成员函数里,你是可以知道this指针的位置的(可以通过&this获得),也可以直接使用它。

-

F. 每个类编译后,是否创建一个类中函数表保存函数指针,以便用来调用函数?

- 普通的类函数(不论是成员函数,还是静态函数)都不会创建一个函数表来保存函数指针。只有虚函数才会被放到函数表中。但是,即使是虚函数,如果编译器能明确知道调用的是哪个函数,编译器就不会通过函数表中的指针来间接调用,而是会直接调用该函数。

-

A. this指针是什么时候创建的?

1.40 stl可以在共享内存上分配吗

STL中支持,自定义allocator分配器,并且允许重载new关键字。对于共享内存可以以共享内存为基础实现内存池。分配并映射对应的数据结构。因此是可以进行分配的。

但是注意因为是基于内存池的内存管理,需要注意越界方式,一旦类超出了共享内存的有效范围,该类无法再分配新的共享内存。

1.41 C++的大小端和判断方法

-

大端模式,是指数据的高字节保存在内存的低地址中,而数据的低字节保存在内存的高地址中,这样的存储模式有点儿类似于把数据当作字符串顺序处理:地址由小向大增加,而数据从高位往低位放;这和我们的阅读习惯一致。

-

小端模式,是指数据的高字节保存在内存的高地址中,而数据的低字节保存在内存的低地址中,这种存储模式将地址的高低和数据位权有效地结合起来,高地址部分权值高,低地址部分权值低。

-

例如:对于内存中存放的数0x12345678来说

- 如果是采用大端模式存放的,则其真实的数是:0x12345678

- 如果是采用小端模式存放的,则其真实的数是:0x78563412

-

确认方法:在union中所有的数据成员共用一个空间,同一时间只能储存其中一个数据成员,所有的数据成员具有相同的起始地址。即上述的union虽然定义了两个成员,但其实这个union只占用了4个字节(32位机器中),往a成员赋值,然后读取b就相读取a成员的低位第一个字节的值。

-

int checkCPUendian()//返回1,为小端;反之,为大端; { union { unsigned int a; unsigned char b; }c; c.a = 1; return 1 == c.b;/* a的最低位字节为1,为小端模式 */ }

-

2. C++ STL

2.1 map和set有什么区别,分别又是怎么实现的?

-

map和set都是STL中的关联容器,其底层实现都是红黑树(RB-Tree)。由于map和set所开放的各种操作接口,RB-tree也都提供了,所以几乎所有的map和set的操作行为,都只是转调RB-tree的操作行为。 -

map和set区别在于:-

map中的元素是key-value(关键字—值)对:关键字起到索引的作用,值则表示与索引相关联的数据;set只是关键字的简单集合,它的每个元素只包含一个关键字。 -

set的迭代器是const的,不允许修改元素的值;而map虽然不允许修改关键字(Key),但是允许修改value。 其原因是map和set都是根据关键字排序来保证其有序性的,如果允许修改key的话,那么首先需要删除该键,然后调节平衡,再插入修改后的键值,调节平衡,如此一来,严重破坏了map和set的结构,导致iterator失效。所以STL中将set的迭代器设置成const,不允许修改迭代器的值;而map的迭代器则不允许修改key值,允许修改value值。 -

map支持下标操作,set不支持下标操作。map可以用key做下标,map的下标运算符[ ]将关键码作为下标去执行查找,如果关键码不存在,则插入一个具有该关键码和mapped_type类型默认值的元素至map中,因此下标运算符[ ]在map应用中需要慎用,const_map不能用,只希望确定某一个关键值是否存在而不希望插入元素时也不应该使用,mapped_type类型没有默认值也不应该使用。如果find能解决需要,尽可能用find。

-

2.2 请你来介绍一下STL的allocator

-

STL的分配器用于封装STL容器在内存管理上的底层细节。 - 在

C++中,其内存配置和释放包括两个关键之:new和delete:-

new运算分两个阶段:1) 调用::operator new配置内存;2) 调用对象构造函数初始化对象 -

delete运算分两个阶段:1) 调用对象析构函数;2) 调用::operator delete释放内存

-

- 在

STL allocator将以上阶段分作四个函数分别负责:allocate函数负责分配内存空间,deallocate函数负责内存释放,construct负责对象构造,destroy负责对象析构. - 为了提升内存管理效率, 减少申请小内存造成的内存碎片化问题,

SGI STL采用两级分配至, 当分配空间的大小超过128B的时候,会使用第一级空间配置器, 当分配空间大小小于128B时,采用第二级空间配置器.- 一级空间配置器直接使用

malloc,realloc,free函数进行内存空间分配和释放. - 二级空间配置器使用内存池技术管理内存, 使用

16个链表维护8-128byte的16级别的小内存块.

- 一级空间配置器直接使用

2.3 STL迭代器删除元素

- 这个主要考察的是迭代器失效的问题。

- 对于序列容器

vector,deque来说,使用erase(itertor)后,后边的每个元素的迭代器都会失效,但是后边每个元素都会往前移动一个位置,但是erase会返回下一个有效的迭代器 - 对于关联容器map set来说,使用了erase(iterator)后,当前元素的迭代器失效,但是其结构是红黑树,删除当前元素的,不会影响到下一个元素的迭代器,所以在调用erase之前,记录下一个元素的迭代器即可。

- 对于list来说,它使用了不连续分配的内存,并且它的erase方法也会返回下一个有效的iterator,因此上面两种正确的方法都可以使用。

- 对于序列容器

- 注意:map的底层结构是红黑树,

unordered map底层结构是哈希表

2.4 STL有什么基本组成

-

STL主要由六大部分组成:配置器,容器,迭代器,算法,适配器,仿函数 - 他们之间的关系:

- 配置器为容器提供空间, 它是对空间动态分配,管理和释放的实现

- 迭代器实现了容器和算法的衔接, 算法通过迭代器获取容器中的内容

- 仿函数可以协助算法完成各种操作,适配器用来套接适配仿函数

- 注意:迭代器不是指针是类模板,通过模拟指针的功能;封装了指针

2.5 vector和list的区别,应用,越详细越好

-

vector: 在堆上分配空间, 连续存储的容器, 支持动态调整空间大小- 底层实现:数组(

array) - 容器内存空间增长:

-

vector增加(插入)新元素时,如果未超过此时的容量(还有剩余空间),那么直接添加到最后(插入指定位置), 然后调整迭代器。 - 如果没有剩余空间了,则会重新配置原有元素个数的两倍空间,然后将原空间元素通过复制的方式初始化新空间,再向新空间增加元素,最后析构并释放原空间,之前的迭代器会失效。

-

- 性能:

- 访问:O(1)

- 插入:

- 在最后插入(空间够):很快

- 在最后插入(空间不够):需要内存申请和释放,以及对之前数据进行拷贝。

- 在中间插入(空间够):内存拷贝

- 在中间插入(空间不够):需要内存申请和释放,以及对之前数据进行拷贝。

- 删除:

- 在最后删除:很快

- 在中间删除:内存拷贝

- 适用场景:经常随机访问,且不经常对非尾节点进行插入删除。

- 底层实现:数组(

-

List动态链表: 在堆上分配空间,每插入一个元数都会分配空间,每删除一个元素都会释放空间。- 底层:双向链表

- 性能:

- 访问:随机访问性能很差,只能快速访问头尾节点。

- 插入:很快,一般是常数开销

- 删除:很快,一般是常数开销

- 适用场景:经常插入删除大量数据

- 区别:

底层,内存的连续性,插入和删除的影响,内存分配时机,随机访问性能-

vector底层实现是数组;list是双向 链表。 -

vector支持随机访问,list不支持。 -

vector是连续的内存空间,list不是。 -

vector在中间节点进行插入删除会导致内存拷贝,list不会。 -

vector一次性分配好内存,不够时才进行2倍扩容;list每次插入新节点都会进行内存申请。 -

vector随机访问性能好,插入删除性能差;list随机访问性能差,插入删除性能好。

-

- 应用

-

vector拥有连续的内存空间,因此支持随机访问,如果需要高效的随即访问,而不在乎插入和删除的效率,使用vector。 -

list拥有不连续的内存空间,如果需要高效的插入和删除,而不关心随机访问,则应使用list。

-

2.6 STL vector的实现,删除其中的元素,迭代器如何变化?为什么是两倍扩容?释放空间?

- vector相关函数:

-

size / capacity: 已用空间 / 总空间 -

resize / reserve: 改变容器的元素数目 / 概念容器的空间大小 -

push_back / pop_back: 尾插 / 尾减 -

insert / erase: 任意位置插入 / 任意位置删除

-

- 迭代器失效问题:

- 在

capacity内insert和erase都会导致在后续元素发生移动, 进而迭代器失效或则改变 - 如果

insert或则push_back导致空间不足, 则会发生整体的移动操作, 所有迭代器都将失效.

- 在

- 两倍扩容问题:

- 为什么呈倍数扩容(时间复杂度更优)

- 对于

n次插入操作, 采用成倍方式扩容可以保证时间复杂度O(n), 而指定大小扩容的时间复杂度为O(n^2)

- 对于

- 为什么是

1.5倍扩容(空间可重用)- 当

k == 2时:- 第n次扩容的时候需要分配的内存是:

an = a1*q^(n-1) = 4*2^(n-1) - 而前n-1项的内存和为:

Sn = a1*(1-q^(n-1))/(1-q) = 4*(1-2^(n-1)) /(1-2) = 4*2^(n-1)-4 差值 = an - Sn = 4 > 0- 所以第

n次扩容需要的空间恰好比前n-1扩容要求的空间总和要大,那么即使在前n-1次分配空间都是连续排列的最好情况下,也无法实现之前的内存空间重用

- 第n次扩容的时候需要分配的内存是:

- 当

k = 1.5时:- 第

n次扩容的时候需要分配的内存是:an = a1*q^(n-1) = 4*1.5^(n-1) - 而前

n-1项的内存和为:Sn = a1*(1-q^(n-1))/(1-q) = 4*(1-1.5^(n-1)) /(1-1.5) = 8*1.5^(n-1)-8 差值 = an - Sn = 8 - 4*1.5^(n-1)- 当

n增长到一定的数值后,差值就会变为小于0,那么如果前n-1次分配的空间都是连续的情况下, 就可以实现内存空间复用

- 第

- 当

- 为什么呈倍数扩容(时间复杂度更优)

- 释放空间:

- 使用

swap:vector<int>().swap(a);

- 使用

- 参考:

3 多线程编程和设计模式

3.1 怎么实现线程池

-

- 设置一个生产者消费者队列,作为临界资源

-

- 初始化

n个线程,并让其运行起来,加锁去队列取任务运行

- 初始化

-

- 当任务队列为空的时候,所有线程阻塞

-

- 当生产者队列来了一个任务后,先对队列加锁,把任务挂在到队列上,然后使用条件变量去通知阻塞中的一个线程

3.2 说一下面向对象设计的基本原则

- 封装:隐藏内部实现

- 继承:复用现有代码

- 多态:改写对象行为

设计模式关键在于分解和抽象;

设计模式的主要目的是易于变化

面向对象设计原则–比设计模式更加重要 违背了设计原则,设计模式是错误的。

- 依赖倒置原则(DIP)/面向接口编程--实现隔离变化;实现尽量依赖抽象,不依赖具体实现。

- 高层模块(稳定)不应该依赖于底层模块(变化),二者都应该依赖于抽象(稳定)。

- 抽象(稳定)不应该依赖于实现细节(变化),细节应该依赖于抽象(稳定)。

- 解释,将需要变动的部分,作为稳定公共抽象基类的子类,将公共方法写在基类中,关键方法作为虚函数交给子类实现。调用公共函数时,只用管理基类指针,使用基类指针调用公共虚函数,就可以调用对应的子函数。实现稳定与不稳定的隔离。

- 开放封闭原则(OCP):

- 对扩展开放,对更改封闭

- 类模块应该是可扩展的,但是不可修改。

- 解释:增加中间抽象,避免过多的更改,保证可扩展性。

- 单一职责原则(SRP)

- 一个类应该仅有一个引起它变化的原因。

- 变化的方向隐含着类的责任

- Liskov替换原则(LSP)–里氏替换原则

- 子类必须能够替换他们的基类(IS-A)

- 继承表达抽象。

- 接口隔离(ISP)

- 不应该强迫客户程序依赖它们不用的方法。

- 接口应该小而完备。

- 适度细化接口,将臃肿的接口拆分为独立的几个接口。

- 合成复用原则(Composite Reuse Principle)优先使用对象组合,而不是类继承

- 继承类通常为”白箱复用”,对象组合通常为”黑箱复用”。

- 继承在某种程度上破坏了封装性,子类父类耦合度高。

- 对象组合则只被要求被组合的对象具有良好定义的接口,耦合度低。

- 迪米特法则(Demeter Principle)

- 类与类之间的关系越密切,耦合度也就越来越大,只有尽量降低类与类之间的耦合才符合设计模式

-

一个对象对另一个对象知道的越少越好,即一个软件实体应当尽可能少的与其他实体发生相互作用,在一个类里能少用多少其他类就少用多少,尤其是局部变量的依赖类,能省略尽量省略。同时如果两个类不必彼此直接通信,那么这两个类就不应当发生直接的相互作用。如果其中一个类需要调用另一个类的某一方法的话,可以通过第三者转发这个调用。

-

封装变化点

- 使用封装来创建对象之间的分界层,让设计者可以在分界层中任意一侧进行修改,而不会对另外一侧产生不良的影响,从而实现层次间的松耦合。

- 针对接口编程,而不是针对实现编程

- 不将变量类型声明为某个具体的类,而是声明为某个接口。

- 客户端程序无需获知对象的具体类型,只需要知道对象所具有的接口。

- 减少系统中各个部分的依赖关系,从而实现“高内聚”、“松耦合”的类型设计方案。

3.3 接口标准化

- 设计习语:描述与特定编程语言相关的低层模式,技巧,惯用法(例如,effictive C++等)

- 设计模式:描述“类与相互通信的对象之间的组织关系,包括它们的角色,职责,协作方式等方面”。

- 架构模式:描述系统中与基本结构组织关系密切的高层模式,包括子系统划分,职责,以及如果组织它们之间关系的规则。

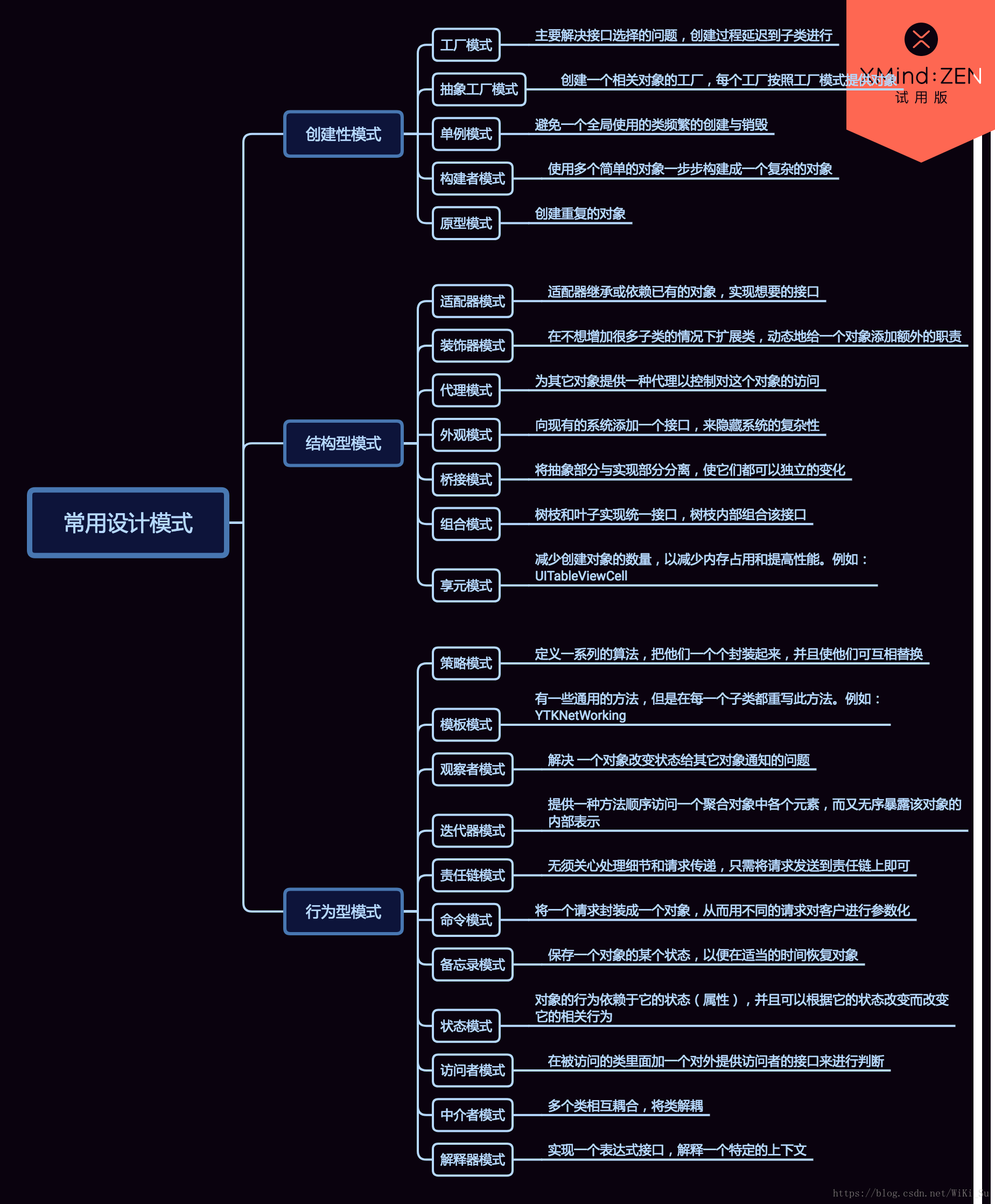

3.4 说一说设计模式的分类

- 从目的来看

- 创建型:将对象的部分创建工作延迟到子类,或者其它对象,从而应对需求变化为对象创建具体的类时,带来的冲击

- 结构型:通过类的继承或者对象的组合获得更加灵活的结构,从而应对需求变化为对象的结构带来的冲击。

- 行为型:通过类继承或者对象的组合,明确类与对象间的职责,从而应对需求变化为多个交互的对象的冲击。

- 从范围来看:

- 类模式处理与子类的静态关系

- 对象模式处理对象之间的动态关系。

- 重构的关键技法

- 静态-> 动态

- 早绑定 -> 晚绑定:前调用后—>后调用前

- 继承 -> 组合

- 编译时依赖 -> 运行时依赖

- 紧耦合 -> 松耦合

- “组建协作”模式:

- “框架与应用”分离,“组件协作”模式通过晚期绑定,来实现框架与应用之间的松耦合,是二者之间协作时常用的模式。

- 模板方法 定义一个操作中的算法的骨架(稳定),而将一些操作(变化)延迟到子类(通常使用虚函数)。Temlpate Method使得子类可以(复用)一个算法的结构即可重定义(override重写);某些特定的步奏。

设计模式的核心,在于查找稳定部分非稳定部分,用不同的模式,来设计两者之间的关系

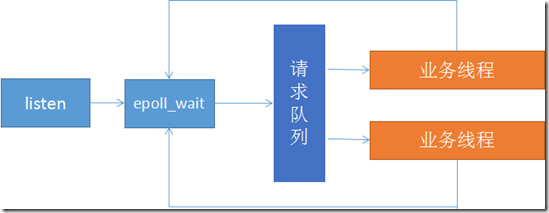

3.5 说一下Reactor和Preactor模式

Reactor和preactor都是IO多路复用模式,一般地,I/O多路复用机制都依赖于一个事件多路分离器(Event Demultiplexer)。分离器对象可将来自事件源的I/O事件分离出来,并分发到对应的read/write事件处理器(Event Handler)。开发人员预先注册需要处理的事件及其事件处理器(或回调函数)。

Reactor模式采用同步IO,而Proactor采用异步IO,事先写入处理方式直接进行操作就可以了。因此Reactor和Proactor模式的主要区别就是真正的读取和写入操作是有谁来完成的,Reactor中需要应用程序自己读取或者写入数据,而Proactor模式中,应用程序不需要进行实际的读写过程,它只需要从缓存区读取或者写入即可,操作系统会读取缓存区或者写入缓存区到真正的IO设备

- Reactor模式:使用同步IO模型,即业务线程处理数据需要主动等待或询问,主要特点是利用epoll监听listen描述符是否有相应,及时将客户连接信息放于一个队列,epoll和队列都是在主进程/线程中,由子进程/线程来接管各个描述符,对描述符进行下一步操作,包括connect和数据读写。主程读写就绪事件。

- Preactor模式:Preactor模式完全将IO处理和业务分离,使用异步IO模型,即内核完成数据处理后主动通知给应用处理,主进程/线程不仅要完成listen任务,还需要完成内核数据缓冲区的映射,直接将数据buff传递给业务线程,业务线程只需要处理业务逻辑即可。

4 操作系统

4.1 进程与线程的概念,以及为什么要有进程线程,其中有什么区别,他们各自又是怎么同步的

- 基本概念:

- 进程

- 是对运行时程序的封装,

- 是系统进行资源调度和分配的的基本单位,

- 实现了操作系统的并发;

- 线程

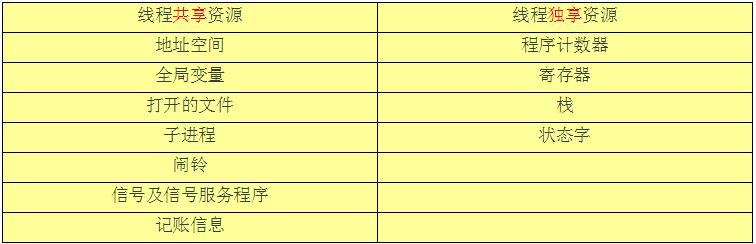

- 是进程的子任务,是

CPU调度和分派的基本单位,用于保证程序的实时性,实现进程内部的并发; - 线程是操作系统可识别的

最小执行和调度单位。 - 每个线程都独自占用一个虚拟处理器:独自的寄存器组,指令计数器和处理器状态(栈也是独立的)。

- 每个线程完成不同的任务,但是共享

- 同一地址空间(也就是同样的动态内存(堆区),映射文件(映射区),目标代码等等)

- 打开的文件队列和其他内核资源。(例如

Socket, 文件句柄什么的)

- 是进程的子任务,是

- 进程

- 有了进程又增加线程的原因:

- 原来存在的问题:

- 进程在同一时间只能干一件事, 进程在执行的过程中如果阻塞,整个进程就会挂起,即使进程中有些工作不依赖于等待的资源,仍然不会执行。

- 引入线程有如下优势:

- 线程所需的资源相对较小

- 线程间切换的代价较小

- 线程间通信方便

- 可以改善程序结构。一个既长又复杂的进程可以考虑分为多个线程,成为几个独立或半独立的运行部分,这样的程序才会利于理解和修改。

- 可以有效利用多核CPU

- 原来存在的问题:

- 区别:

- 1) 一个线程只能属于一个进程,而一个进程可以有多个线程,但至少有一个线程。线程依赖于进程而存在。

- 2) 进程在执行过程中拥有独立的内存单元,而多个线程共享进程的内存。

- 资源分配给进程,同一进程的所有线程共享该进程的所有资源。

- 同一进程中的多个线程共享代码段(代码和常量),数据段(全局变量和静态变量),扩展段(堆存储)。

- 但是每个线程拥有自己的栈段,栈段又叫运行时段,用来存放所有局部变量和临时变量。

- 3) 进程是资源分配的最小单位,线程是CPU调度的最小单位;

- 4) 系统开销:进程切换的开销也远大于线程切换的开销。

- 由于在创建或撤消进程时,系统都要为之分配或回收资源,如内存空间、I/O设备等。因此,操作系统所付出的开销将显著地大于在创建或撤消线程时的开销。

- 在进行进程切换时,涉及到整个当前进程CPU环境的保存以及新被调度运行的进程的CPU环境的设置。

- 而线程切换只须保存和设置少量寄存器的内容,并不涉及存储器管理方面的操作。

- 5) 通信:

- 同一进程中的多个线程具有相同的地址空间,致使它们之间的同步和通信的实现,也变得比较容易。线程间可以直接读写进程数据段(如全局变量)来进行通信——需要进程同步和互斥手段的辅助,以保证数据的一致性。

- 而

进程间通信IPC主要包括: 管道,系统IPC(包括消息队列、信号量、信号、共享内存等) 以及套接字socket。

- 进程编程调试简单可靠性高,但是创建销毁开销大;线程正相反,开销小,切换速度快,但是编程调试相对复杂。

- 进程间不会相互影响 ;线程一个线程挂掉将导致整个进程挂掉

- 进程适应于多核、多机分布;线程适用于多核

4.2 两个进程访问临界区资源,会不会出现都获得自旋锁的情况?

- 自旋锁:

- 自旋锁的实现主要有三种方式:

- 单核不可抢占内核, 自旋锁为空,即什么都不干

- 单核可抢占内核, 除了设置

禁止内核抢占之外,什么都不干 - 多核可抢占内核, 设置

禁止内核抢占+自旋

-

注意: 禁止内核抢占只是关闭“可抢占标志”,而不是禁止进程切换。显式使用

schedule或进程阻塞(此也会导致调用schedule)时,还是会发生进程调度的。 - 所以单核可抢占模式下,就会发生两个进程都获得了临界资源的情况:

-

即 某一个进程获得了自旋锁,然后阻塞掉了,另一个进程继续获取自选锁,因为资源所为空嘛,所以依旧是可能的

-

- 自旋锁应发死锁的情况

- 阻塞

- 函数调用

- 中断

4.3 请你来说一下awk的使用

- Linux三剑客之awk命令

-

awk是一个文本分析工具, 它将文件逐行读取, 然后使用分隔符进行切片, 再对切开的部分进行各种处理 - 使用方法:

awk -F ':' '{pattern + action }' filename-

-F:后面跟着分隔符, 使用'[xxx]'可以设置多种分割符 -

pattern: 支持正则表达式 -

action:BEGIN,END,print,printf以及类似c语言的逻辑操作

-

- 内置变量:

-

ARGV/ARGC:命令行参数列表/数量 -

ENVIRON: 系统变量 -

FILENAME: 文件名 -

FNR: 浏览文件的数量 -

NR: 行数 -

FS: 列数(切片数) -

$0: 行 -

${1...n}: 第几个列(切片)

-

4.4 进程间通信的方式:

- 进程间通信主要包括

管道、系统IPC(包括消息队列、信号量、信号、共享内存等)、以及套接字socket。- 管道:管道主要包括无名管道和命名管道, 管道可用于具有亲缘关系的父子进程间的通信,有名管道除了具有管道所具有的功能外,它还允许无亲缘关系进程间的通信

- 普通管道

PIPE: 1) 它是半双工的(即数据只能在一个方向上流动),具有固定的读端和写端 2) 它只能用于具有亲缘关系的进程之间的通信(也是父子进程或者兄弟进程之间) 3) 它可以看成是一种特殊的文件,对于它的读写也可以使用普通的read、write等函数。但是它不是普通的文件,并不属于其他任何文件系统,并且只存在于内存中。#include <stdio.h> /* 父进程和子进程管道 */ FILE *popen(const char* command,const char *open_mode); int pclose(FILE *stream_to_close); #include <unistd.h> /* 注意两个文件描述符0 read 1 write */ int pipe(int file_descriptor[2]); - 命名管道

FIFO: 1)FIFO可以在无关的进程之间交换数据 2)FIFO有路径名与之相关联,它以一种特殊设备文件形式存在于文件系统中。 3) 可以使用mkfifo filename或者mknod filenamep来创建命名管道#include <sys/types.h> #include <sys/stat.h> /* 获取管道信息 */ int mkinfo(const char *filename,mode_t mode); /* 更改管道 */ int mknod(const char *filename,mode_t mode | S_IFIFO, (dev_t)0); //使用open打开FIFO文件,不能设置读写模式;只能设置成为单一模式,即:O_RDONLY、O_WRONLY和O_NONBLOCK方式进行。

- 普通管道

- 系统

IPC- 消息队列

- 消息队列,是消息的链接表,存放在内核中。一个消息队列由一个标识符(即

队列ID)来标记。 (消息队列克服了信号传递信息少,管道只能承载无格式字节流以及缓冲区大小受限等特点)具有写权限得进程可以按照一定得规则向消息队列中添加新信息;对消息队列有读权限得进程则可以从消息队列中读取信息;

- 消息队列,是消息的链接表,存放在内核中。一个消息队列由一个标识符(即

- 特点:

1) 消息队列是面向记录的,其中的消息具有特定的格式以及特定的优先级。

2) 消息队列独立于发送与接收进程。进程终止时,消息队列及其内容并不会被删除。

3) 消息队列可以实现消息的随机查询,消息不一定要以先进先出的次序读取,也可以按消息的类型读取。

#include <sys/msg.h> /* 控制 */ int msgctl(int msqid,int cmd,struct msqid_ds *buf); /* 消息队列的获取 */ int msgget(key_t key,int msgflg); /* 消息队列的接收 */ int msgrcv(int msgid,void *msg_ptr,size_t msg_sz,long int msgtype,int msgflg); /* 消息队列发送 */ int msgsnd(int msqid,const void *msg_ptr,size_t mag_sz,int magflg);

- 消息队列

- 信号量

semaphore- 信号量(semaphore)与已经介绍过的

IPC结构不同,它是一个计数器,可以用来控制多个进程对共享资源的访问。信号量用于实现进程间的互斥与同步,而不是用于存储进程间通信数据。 - 特点:

1) 信号量用于进程间同步,若要在进程间传递数据需要结合共享内存。

2) 信号量基于操作系统的

PV操作,程序对信号量的操作都是原子操作。 3) 每次对信号量的PV操作不仅限于对信号量值加 1或减 1,而且可以加减任意正整数。 4) 支持信号量组。#include <sys/sem.h> //控制信号量 int semctl(int sem_id,int sem_num,int comman,...); //创建一个新信号量或者取得一个已有信号量的键,num_sems函数基本都为1 int semget(key_t key,int num_sems,int sem_flags); //更改信号量 int semop(int sem_id,struct sembuf *sen_ops,size_t num_sem_ops);

- 信号量(semaphore)与已经介绍过的

-

信号signal: 信号是一种比较复杂的通信方式,用于通知接收进程某个事件已经发生。 -

共享内存(Shared Memory):它使得多个进程可以访问同一块内存空间,不同进程可以及时看到对方进程中对共享内存中数据得更新。这种方式需要依靠某种同步操作,如互斥锁和信号量等- 特点:

1) 共享内存是最快的一种

IPC,因为进程是直接对内存进行存取 2) 因为多个进程可以同时操作,所以需要进行同步 3) 信号量+共享内存通常结合在一起使用,信号量用来同步对共享内存的访问#include <sys/shm.h> /* 共享内存连接到进程地址空间 */ void *shmat(int shm_id,const void *shm_addr,int shmflg); /* 控制 */ int shmctl(int shm_id,int cmd,struct shmid_ds *buf); /* 分离共享内存 */ int shmdt(const void *shm_addr); /* 根据key创建共享内存 */ int shmget(key_t key,size_t size,int shmflg);

- 特点:

1) 共享内存是最快的一种

-

套接字

SOCKET:-

socket也是一种进程间通信机制,与其他通信机制不同的是,它可用于不同主机之间的进程通信。

-

- 管道:管道主要包括无名管道和命名管道, 管道可用于具有亲缘关系的父子进程间的通信,有名管道除了具有管道所具有的功能外,它还允许无亲缘关系进程间的通信

4.5 线程间通信的方式:

- 线程间通信的方式: 临界区, 互斥量, 信号量, 信号

-

临界区:通过多线程的串行化来访问公共资源或一段代码,速度快,适合控制数据访问; -

互斥量Synchronized/Lock:采用互斥对象机制,只有拥有互斥对象的线程才有访问公共资源的权限。因为互斥对象只有一个,所以可以保证公共资源不会被多个线程同时访问 -

信号量Semphare:实际上是一个计数器,为控制具有有限数量的用户资源而设计的,它允许多个线程在同一时刻去访问同一个资源,但一般需要限制同一时刻访问此资源的最大线程数目。 -

事件(信号) Wait/Notify:通过通知操作的方式来保持多线程同步,还可以方便的实现多线程优先级的比较操作

-

4.6 虚拟内存的特点

- 好处:

- 扩大

寻址空间和可寻址空间 - 内存保护

- 内存共享

- 和缺页中断配合实现虚拟储存技术(参考: 进程状态转换图,动态就绪,静态就绪,动态阻塞,静态阻塞)

- 扩大

- 虚拟内存的代价:

- 虚存的管理需要建立很多数据结构,这些数据结构要占用额外的内存

- 虚拟地址到物理地址的转换,增加了指令的执行时间。

- 页面的换入换出需要

磁盘I/O,这是很耗时的 - 如果一页中只有一部分数据,会浪费内存。

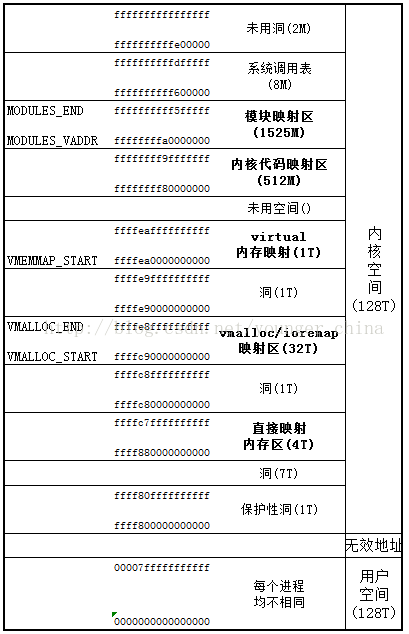

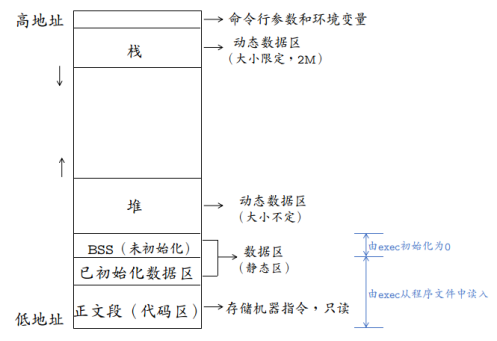

4.7 Linux中的程序内存结构

操作系统中的程序的内存结构

4.8 fork和vfork的区别:

-

fork( )的子进程拷贝父进程的数据段和代码段;vfork( )的子进程与父进程共享数据段 -

fork( )的父子进程的执行次序不确定;vfork( )保证子进程先运行,在调用exec或exit之前与父进程数据是共享的,在它调用exec或exit之后父进程才可能被调度运行。 -

vfork( )保证子进程先运行,在它调用exec或exit之后父进程才可能被调度运行 。 如果在调用这两个函数之前子进程依赖于父进程的进一步动作,则会 导致死锁。 - 当需要改变共享数据段中变量的值,则拷贝父进程。

- 补充知识点:写时复制

-

Linux采用了写时复制的方法,以减少fork时对父进程空间进程整体复制带来的开销。 - 写时复制是一种采取了惰性优化方法来避免复制时的系统开销。

- 它的前提很简单:

- 如果有多个进程要读取它们自己的那部分资源的副本,那么复制是不必要的。

- 每个进程只要保存一个指向这个资源的指针就可以了。

- 只要没有进程要去修改自己的“副本”,就存在着这样的幻觉:每个进程好像独占那个资源。

- 从而就避免了复制带来的负担。如果一个进程要修改自己的那份资源“副本”,那么就会复制那份资源,并把复制的那份提供给进程。

- 不过其中的复制对进程来说是透明的。这个进程就可以修改复制后的资源了,同时其他的进程仍然共享那份没有修改过的资源。

- 所以这就是名称的由来:在写入时进行复制。

- 写时复制的主要好处在于:如果进程从来就不需要修改资源,则不需要进行复制。惰性算法的好处就在于它们尽量推迟代价高昂的操作,直到必要的时刻才会去执行。

- 在使用虚拟内存的情况下,写时复制(

Copy-On-Write)是以页为基础进行的。所以,只要进程不修改它全部的地址空间,那么就不必复制整个地址空间。在fork( )调用结束后,父进程和子进程都相信它们有一个自己的地址空间,但实际上它们共享父进程的原始页,接下来这些页又可以被其他的父进程或子进程共享。 - 写时复制在内核中的实现非常简单。与内核页相关的数据结构可以被标记为只读和写时复制。如果有进程试图修改一个页,就会产生一个缺页中断。内核处理缺页中断的方式就是对该页进行一次透明复制。这时会清除页面的COW属性,表示着它不再被共享。

- 现代的计算机系统结构中都在内存管理单元

(MMU)提供了硬件级别的写时复制支持,所以实现是很容易的。 - 在调用

fork( )时,写时复制是有很大优势的。因为大量的fork之后都会跟着执行exec,那么复制整个父进程地址空间中的内容到子进程的地址空间完全是在浪费时间:如果子进程立刻执行一个新的二进制可执行文件的映像,它先前的地址空间就会被交换出去。写时复制可以对这种情况进行优化。

-

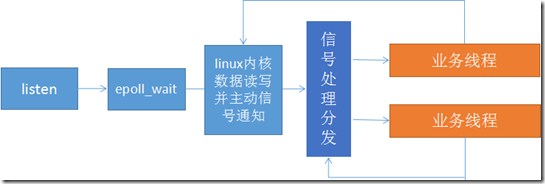

4.9 操作系统中的页表寻址

- 页式内存管理,内存分成固定长度的一个个页片。

- 操作系统为每一个进程维护了一个从虚拟地址到物理地址的映射关系的数据结构,叫页表,页表的内容就是该进程的虚拟地址到物理地址的一个映射。页表中的每一项都记录了这个页的基地址。

- 通过页表,由逻辑地址的高位部分先找到逻辑地址对应的页基地址,再由页基地址偏移一定长度就得到最后的物理地址,偏移的长度由逻辑地址的低位部分决定。一般情况下,这个过程都可以由硬件完成,所以效率还是比较高的。

- 页式内存管理的优点就是比较灵活,内存管理以较小的页为单位(内存碎片的最小单位为页),方便内存换入换出和扩充地址空间。

-

优点:

- 页面都用固定的长度, 页表简单,调如方便

-

缺点:

- 程序不可能正好是页面的整数倍, 所以最后一页的零头将会浪费

- 页不是逻辑上的独立实体,所以处理, 保护和共享都不级段式虚拟存储

-

Linux最初的两级页表机制:- 两级分页机制将

32位的虚拟空间分成三段,分别表示页目录表项,页表项,内页偏移, 虚拟地址高10位表示页目录表偏移, 中间10位表示页表偏移, 低12位表示页内偏移 - 低十二位表示

页内偏移,高20分成两段分别表示两级页表的偏移。-

PGD(Page Global Directory): 最高10位,全局页目录表索引 -

PTE(Page Table Entry):中间10位,页表入口索引 - 其中的计算关系为:

- 一页的大小为

4K, 页表项索引的大小为4bytes, 所以一页中可以存放1024(2$^{10}$)个页表项- 对于页目录表 就是一页存放了

1024个页表项索引 - 对于页表就是 一页可以存放

1024页索引

- 对于页目录表 就是一页存放了

- 一页的大小为

-

- 当在进行地址转换时,

- 首先

CR3寄存器中存放的全局页目录表(page directory, PGD)的这一页的物理地址 - 再加上从虚拟地址中抽出

高10位叫做页目录表项(内核也称这为pgd)的部分作为偏移, 即定位到可以描述该地址的pgd;从该pgd中可以获取可以描述该地址的页表的物理地址, - 再加上从虚拟地址中

抽取中间10位作为偏移, 即定位到可以描述该地址的pte; - 在这个

pte中即可获取该地址对应的页的物理地址, 加上从虚拟地址中抽取的最后12位,即形成该页的页内偏移, 即可最终完成从虚拟地址到物理地址的转换。 - 从上述过程中,可以看出,对虚拟地址的分级解析过程,实际上就是不断深入页表层次,逐渐定位到最终地址的过程,所以这一过程被叫做

page talbe walk。

- 首先

- 两级分页机制将

-

Linux的三级页表机制:- 当

X86引入物理地址扩展(Pisycal Addrress Extension, PAE)后,可以支持大于4G的物理内存(36位),但虚拟地址依然是32位,原先的页表项不适用,它实际多4 bytes被扩充到8 bytes,这意味着,每一页现在能存放的pte数目从1024变成512了(4k/8)。相应地,页表层级发生了变化,Linux新增加了一个层级,叫做页中间目录(page middle directory, PMD), 变成:

字段 描述 位数 cr3 指向一个PDPT crs寄存器存储 PGD 指向PDPT中4个项中的一个 位31~30 PMD 指向页目录中512项中的一个 位29~21 PTE 指向页表中512项中的一个 位20~12 page offset 4KB页中的偏移 位11~0 - 现在就同时存在2级页表和3级页表,在代码管理上肯定不方便。巧妙的是,

Linux采取了一种抽象方法:所有架构全部使用3级页表: 即PGD -> PMD -> PTE。 - 那只使用2级页表(如非PAE的X86)怎么办?

- 办法是针对使用2级页表的架构,把

PMD抽象掉,即虚设一个PMD表项。这样在page table walk过程中,PGD本直接指向PTE的,现在不了,指向一个虚拟的PMD,然后再由PMD指向PTE。这种抽象保持了代码结构的统一。

- 办法是针对使用2级页表的架构,把

- 当

-

Linux的四级页表机制:- 硬件在发展,3级页表很快又捉襟见肘了,原因是

64位CPU出现了, 比如X86_64, 它的硬件是实实在在支持4级页表的。它支持48位的虚拟地址空间。如下:

字段 描述 位数 PML4 指向一个PDPT 位47~39 PGD 指向PDPT中512个项中的一个 位38~30 PMD 指向页目录中512项中的一个 位29~21 PTE 指向页表中512项中的一个 位20~12 page offset 4KB页中的偏移 位11~0 - Linux内核针为使用原来的3级列表

(PGD->PMD->PTE),做了折衷。即采用一个唯一的,共享的顶级层次,叫PML4。这个PML4没有编码在地址中,这样就能套用原来的3级列表方案了。不过代价就是,由于只有唯一的PML4, 寻址空间被局限在(239=)512G, 而本来PML4段有9位, 可以支持512个PML4表项的。现在为了使用3级列表方案,只能限制使用一个, 512G的空间很快就又不够用了,解决方案呼之欲出。 - 在2004年10月,当时的

X86_64架构代码的维护者Andi Kleen提交了一个叫做4 level page tables for Linux的PATCH系列,为Linux内核带来了4级页表的支持。在他的解决方案中,不出意料地,按照X86_64规范,新增了一个PML4的层级, 在这种解决方案中,X86_64拥一个有512条目的PML4, 512条目的PGD, 512条目的PMD, 512条目的PTE。对于仍使用3级目录的架构来说,它们依然拥有一个虚拟的PML4,相关的代码会在编译时被优化掉。 这样,就把Linux内核的3级列表扩充为4级列表。这系列PATCH工作得不错,不久被纳入Andrew Morton的-mm树接受测试。不出意外的话,它将在v2.6.11版本中释出。但是,另一个知名开发者Nick Piggin提出了一些看法,他认为Andi的Patch很不错,不过他认为最好还是把PGD作为第一级目录,把新增加的层次放在中间,并给出了他自己的Patch:alternate 4-level page tables patches。Andi更想保持自己的PATCH, 他认为Nick不过是玩了改名的游戏,而且他的PATCH经过测试很稳定,快被合并到主线了,不宜再折腾。不过Linus却表达了对Nick Piggin的支持,理由是Nick的做法conceptually least intrusive。毕竟作为Linux的扛把子,稳定对于Linus来说意义重大。最终,不意外地,最后Nick Piggin的PATCH在v2.6.11版本中被合并入主线。在这种方案中,4级页表分别是:PGD -> PUD -> PMD -> PTE。

- 硬件在发展,3级页表很快又捉襟见肘了,原因是

4.10 单核机器上写多线程程序,是否需要考虑加锁,为什么?

- 在单核机器上写多线程程序,仍然需要线程锁。

- 因为线程锁通常用来实现线程的同步和通信。

- 在单核机器上的多线程程序,仍然存在线程同步的问题。

- 因为在抢占式操作系统中,通常为每个线程分配一个时间片,当某个线程时间片耗尽时,操作系统会将其挂起,然后运行另一个线程。

- 如果这两个线程共享某些数据,不使用线程锁的前提下,可能会导致共享数据修改引起冲突。

4.11 线程间的同步方式,最好说出具体的系统调用

- 信号量

- 信号量是一种特殊的变量,可用于线程同步。它只取自然数值,并且只支持两种操作:

-

P(SV):如果信号量SV大于0,将它减一;如果SV值为0,则挂起该线程。 -

V(SV):如果有其他进程因为等待SV而挂起,则唤醒,然后将SV+1;否则直接将SV+1。

-

- 其系统调用为:

-

sem_wait(sem_t *sem): 以原子操作的方式将信号量减1,如果信号量值为0,则sem_wait将被阻塞,直到这个信号量具有非0值。 -

sem_post(sem_t *sem): 以原子操作将信号量值+1。当信号量大于0时,其他正在调用sem_wait等待信号量的线程将被唤醒。

-

- 信号量是一种特殊的变量,可用于线程同步。它只取自然数值,并且只支持两种操作:

- 互斥量

- 互斥量又称互斥锁,主要用于线程互斥,不能保证按序访问,可以和条件锁一起实现同步。

- 当进入临界区时,需要获得互斥锁并且加锁;

- 当离开临界区时,需要对互斥锁解锁,以唤醒其他等待该互斥锁的线程。

- 其主要的系统调用如下:

-

pthread_mutex_init:初始化互斥锁 -

pthread_mutex_destroy:销毁互斥锁 -

pthread_mutex_lock:以原子操作的方式给一个互斥锁加锁,如果目标互斥锁已经被上锁,pthread_mutex_lock调用将阻塞,直到该互斥锁的占有者将其解锁。 -

pthread_mutex_unlock:以一个原子操作的方式给一个互斥锁解锁。

-

- 互斥量又称互斥锁,主要用于线程互斥,不能保证按序访问,可以和条件锁一起实现同步。

- 条件变量

- 条件变量,又称条件锁,用于在线程之间同步共享数据的值。

- 条件变量提供一种线程间通信机制:

- 当某个共享数据达到某个值时,唤醒等待这个共享数据的一个/多个线程。

- 当某个共享变量等于某个值时,调用

signal/broadcast。此时操作共享变量时需要加锁。

- 其主要的系统调用如下:

-

pthread_cond_init:初始化条件变量 -

pthread_cond_destroy:销毁条件变量 -

pthread_cond_signal:唤醒一个等待目标条件变量的线程。哪个线程被唤醒取决于调度策略和优先级。 -

pthread_cond_wait:等待目标条件变量。需要一个加锁的互斥锁确保操作的原子性。该函数中在进入wait状态前首先进行解锁,然后接收到信号后会再加锁,保证该线程对共享资源正确访问。

-

- 这玩意儿是个坑, 一个条件变量可以被signal唤醒,也可以被broadcast唤醒, 所以我们使用它的时候要配合while循环弄一个重陷入机制, 在stl中的condition_variable的底层就是这个

4.12 进程和线程的区别

- 进程是资源分配的最小单位,线程是调度的最小单位。

- 进程有独立的系统资源,而同一进程内的线程共享进程的大部分系统资源,包括堆、代码段、数据段,每个线程只拥有一些在运行中必不可少的私有属性,比如

线程控制块(tcb),线程Id,栈、寄存器。 - 一个进程崩溃,不会对其他进程产生影响;而一个线程崩溃,会让同一进程内的其他线程也死掉。

- 进程在创建、切换和销毁时开销比较大,而线程比较小。

- 进程切换需要:1. 切换页目录以使用新的地址空间;2. 切换内核栈;3. 切换硬件上下文

- 线程只需要2.3

- 协程属于线程,协程在线程里面运行,协程基本没有内核切换的开销,协程的调度是用户手动切换的,因此更加灵活;原子操作性,因为是用户调度的,所以无需原子操作锁。

- 进程创建的时候需要分配系统资源,而销毁的的时候需要释放系统资源。

- 进程切换需要分两步:

- 切换页目录、刷新

TLB(Translation Lookaside Buffer, 页表缓存)以使用新的地址空间; - 切换内核栈和硬件上下文(寄存器);

- 而同一进程的线程间逻辑地址空间是一样的,不需要切换页目录、刷新

TLB。

- 切换页目录、刷新

- 进程间通信比较复杂,而同一进程的线程由于共享代码段和数据段,所以通信比较容易。

4.13 死锁发生的条件以及如何解决死锁

- 死锁是指两个或两个以上进程在执行过程中,因争夺资源而造成的相互等待的现象。

- 死锁发生的四个必要条件如下:

- 互斥条件:进程对所分配到的资源不允许其他进程访问,若其他进程访问该资源,只能等待,直至占有该资源的进程使用完成后释放该资源;

- 请求和保持条件:进程获得一定的资源后,又对其他资源发出请求,但是该资源可能被其他进程占有,此时请求阻塞,但该进程不会释放自己已经占有的资源

- 不可剥夺条件:进程已获得的资源,在未完成使用之前,不可被剥夺,只能在使用后自己释放

- 环路等待条件:进程发生死锁后,必然存在一个进程-资源之间的环形链

- 解决死锁的方法即破坏上述四个条件之一,主要方法如下:

- 资源一次性分配,从而剥夺请求和保持条件

- 可剥夺资源:即当进程新的资源未得到满足时,释放已占有的资源,从而破坏不可剥夺的条件

- 资源有序分配法:系统给每类资源赋予一个序号,每个进程按编号递增的请求资源,释放则相反,从而破坏环路等待的条件。

4.14 虚拟内存置换的方式

- 比较常见的内存替换算法有:

FIFO,LRU,LFU,LRU-K,2Q。 -

FIFO(先进先出淘汰算法)- 思想:最近刚访问的,将来访问的可能性比较大。

- 实现:使用一个队列,新加入的页面放入队尾,每次淘汰队首的页面,即最先进入的数据,最先被淘汰。

- 弊端:无法体现页面冷热信息

-

LFU(最不经常访问淘汰算法)- 思想:如果数据过去被访问多次,那么将来被访问的频率也更高。

- 实现:每个数据块一个引用计数,所有数据块按照引用计数排序,具有相同引用计数的数据块则按照时间排序。每次淘汰队尾数据块。

- 开销:排序开销。

- 弊端:缓存颠簸。

-

LRU(最近最少使用替换算法)- 思想:如果数据最近被访问过,那么将来被访问的几率也更高。

- 实现:使用一个栈,新页面或者命中的页面则将该页面移动到栈底,每次替换栈顶的缓存页面。

- 优点:LRU算法对热点数据命中率是很高的。

- 缺陷: 1) 缓存颠簸,当缓存(1,2,3)满了,之后数据访问(0,3,2,1,0,3,2,1。。。)。 2) 缓存污染,突然大量偶发性的数据访问,会让内存中存放大量冷数据。

-

LRU-K(LRU-2、LRU-3)- 思想:最久未使用K次淘汰算法。

- LRU-K中的K代表最近使用的次数,因此LRU可以认为是LRU-1。LRU-K的主要目的是为了解决LRU算法“缓存污染”的问题,其核心思想是将“最近使用过1次”的判断标准扩展为“最近使用过K次”。 相比LRU,LRU-K需要多维护一个队列,用于记录所有缓存数据被访问的历史。只有当数据的访问次数达到K次的时候,才将数据放入缓存。当需要淘汰数据时,LRU-K会淘汰第K次访问时间距当前时间最大的数据。

- 实现: 1) 数据第一次被访问,加入到访问历史列表; 2) 如果数据在访问历史列表里后没有达到K次访问,则按照一定规则(FIFO,LRU)淘汰; 3) 当访问历史队列中的数据访问次数达到K次后,将数据索引从历史队列删除,将数据移到缓存队列中,并缓存此数据,缓存队列重新按照时间排序; 4) 缓存数据队列中被再次访问后,重新排序; 5) 需要淘汰数据时,淘汰缓存队列中排在末尾的数据,即:淘汰“倒数第K次访问离现在最久”的数据。

- 针对问题:

- LRU-K的主要目的是为了解决LRU算法“缓存污染”的问题,其核心思想是将“最近使用过1次”的判断标准扩展为“最近使用过K次”。

-

2Q- 类似LRU-2。使用一个FIFO队列和一个LRU队列。

- 实现: 1) 新访问的数据插入到FIFO队列; 2) 如果数据在FIFO队列中一直没有被再次访问,则最终按照FIFO规则淘汰; 3) 如果数据在FIFO队列中被再次访问,则将数据移到LRU队列头部; 4) 如果数据在LRU队列再次被访问,则将数据移到LRU队列头部; 5) LRU队列淘汰末尾的数据。

- 针对问题:LRU的缓存污染

- 弊端:

- 当FIFO容量为2时,访问负载是:ABCABCABC会退化为FIFO,用不到LRU。

4.15 进程状态转换图,动态就绪,静态就绪,动态阻塞,静态阻塞

- 进程的五种基本状态:

- 创建状态:进程正在被创建

- 就绪状态:进程被加入到就绪队列中等待CPU调度运行

- 执行状态:进程正在被运行

- 等待阻塞状态:进程因为某种原因,比如等待I/O,等待设备,而暂时不能运行。

-

终止状态:进程运行完毕

- 交换技术

- 当多个进程竞争内存资源时,会造成内存资源紧张,并且,如果此时没有就绪进程,处理机会空闲,I/0速度比处理机速度慢得多,可能出现全部进程阻塞等待I/O。

- 针对以上问题,提出了两种解决方法: 1) 交换技术:换出一部分进程到外存,腾出内存空间。 2) 虚拟存储技术:每个进程只能装入一部分程序和数据。

- 在交换技术上

- 将内存暂时不能运行的进程,或者暂时不用的数据和程序,换出到外存,来腾出足够的内存空间,把已经具备运行条件的进程,或进程所需的数据和程序换入到内存。从而出现了进程的挂起状态:进程被交换到外存,进程状态就成为了挂起状态。

- 活动阻塞,静止阻塞,活动就绪,静止就绪 1) 活动阻塞:进程在内存,但是由于某种原因被阻塞了。 2) 静止阻塞:进程在外存,同时被某种原因阻塞了。 3) 活动就绪:进程在内存,处于就绪状态,只要给CPU和调度就可以直接运行。 4) 静止就绪:进程在外存,处于就绪状态,只要调度到内存,给CPU和调度就可以运行。

- 从而出现了(七状态转换):

- 1, 2 活动就绪 <——> 静止就绪 (内存不够,调到外存)

- 3, 4 活动阻塞 <——> 静止阻塞 (内存不够,调到外存)

- 5, 6 活动就绪 <——> 执行

- 7 执行 ——> 活动阻塞 (被某种原因阻塞)

- 8 执行 ——> 终止

4.16 内存溢出和内存泄漏

- 内存溢出

- 概念:

- 指程序申请内存时,没有足够的内存供申请者使用。

- 内存溢出就是你要的内存空间超过了系统实际分配给你的空间,此时系统相当于没法满足你的需求,就会报内存溢出的错误

- 内存溢出原因:

- 内存中加载的数据量过于庞大,如一次从数据库取出过多数据

- 集合类中有对对象的引用,使用完后未清空,使得不能回收

- 代码中存在死循环或循环产生过多重复的对象实体

- 使用的第三方软件中的

BUG - 启动参数内存值设定的过小

-

解决方案:

- 在linux下面使用mtrace来检查一般程序的内存溢出

- 具体步骤:

- 在需要跟踪的程序中需要包含头文

,而且在main()函数的最开始包含一个函数调用mtrace()。由于在main函数的最开头调用了mtrace(),所以该进程后面的一切分配和释放内存的操都可以由mtrace来跟踪和分析。 - 定义一个环境变量,用来指示一个文件。该文件用来输出log信息。如下的例子:

$export MALLOC_TRACE=mymemory.log - 正常运行程序。此时程序中的关于内存分配和释放的操作都可以记录下来。

- 然后用mtrace使用工具来分析log文件。

- 在需要跟踪的程序中需要包含头文

-

使用valgrind进行内存调式和分析

- 概念:

- 内存泄漏(memory leak):是指由于疏忽或错误造成了程序未能释放掉不再使用的内存的情况。内存泄漏并非指内存在物理上的消失,而是应用程序分配某段内存后,由于设计错误,失去了对该段内存的控制,因而造成了内存的浪费。

- 内存泄漏的分类:

- 堆内存泄漏 (

Heap leak):new创建的堆上数据没有释放 - 系统资源泄露(Resource Leak):主要指程序使用系统分配的资源比如 Bitmap,handle,socket等没有使用相应的函数释放掉,导致系统资源的浪费,严重可导致系统效能降低,系统运行不稳定。 - 没有将基类的析构函数定义为虚函数。当基类指针指向子类对象时,如果基类的析构函数不是virtual,那么子类的析构函数将不会被调用,子类的资源没有正确是释放,因此造成内存泄露。 - 如何排除

- 使用工具软件

BoundsChecker,BoundsChecker是一个运行时错误检测工具,它主要定位程序运行时期发生的各种错误;调试运行DEBUG版程序,运用以下技术:CRT(C run-time libraries)、运行时函数调用堆栈、内存泄漏时提示的内存分配序号(集成开发环境OUTPUT窗口),综合分析内存泄漏的原因,排除内存泄漏。

- 使用工具软件

- 解决方法

- 智能指针。

- 检查、定位内存泄漏

- 检查方法:在

main函数最后面一行,加上一句_CrtDumpMemoryLeaks()。调试程序,自然关闭程序让其退出,查看输出:输出这样的格式{453}normal block at 0x02432CA8,868 bytes long被{}包围的453就是我们需要的内存泄漏定位值,868 bytes long就是说这个地方有868比特内存没有释放。

- 检查方法:在

- 定位代码位置

- 在

main函数第一行加上_CrtSetBreakAlloc(453);意思就是在申请453这块内存的位置中断。然后调试程序,程序中断了,查看调用堆栈。加上头文件#include <crtdbg.h>4.17 常用线程模型

- 在

- 内存泄漏的分类:

- 堆内存泄漏 (

-

Future模型- 核心思想是异步调用

- 传统的同步方法,当客户端发出

call请求,需要很长的一段时间才会返回,客户端一直在等待直到数据返回随后再进行其他任务的处理。 -

Future模型虽然call本身任然需要一段很长时间处理程序。但是服务程序并不等数据处理完成便立即返回客户端一个伪造的数据(如:商品的订单,而不是商品本身),实现了Future模式的客户端在得到这个返回结果后并不急于对其进行处理而是调用其他业务逻辑,充分利用等待时间,这就是Future模式的核心所在。在完成其他业务处理后,最后再使用返回比较慢的Future数据。这样在整个调用中就不存在无谓的等待,充分利用所有的时间片,从而提高了系统响应速度。 - 该模型通常在使用的时候需要结合

Callable接口配合使用。 -

Future是把结果放在将来获取,当前主线程并不急于获取处理结果。 - 允许子线程先处理一段时间,处理结束之后就把结果保存下来,当主线程需要使用的时候再向子线程索取。

-

Callable是类似于Runnable的接口,其中call方法类似于run方法,所不同的是run方法不能抛出受检异常没有返回值,而call方法则可以抛出受检异常并可设置返回值。两者的方法体都是线程执行体。

-

fork & join模型- 该模型包含递归思想和回溯思想,递归用来拆分任务,回溯用合并结果。可以用来处理一些可以进行拆分的大任务。

- 其主要是把一个大任务逐级拆分为多个子任务,然后分别在子线程中执行,当每个子线程执行结束之后逐级回溯,返回结果进行汇总合并,最终得出想要的结果。

- 这里模拟一个摘苹果的场景:

- 有100棵苹果树,每棵苹果树有10个苹果,现在要把他们摘下来。

- 为了节约时间,规定每个线程最多只能摘10棵苹树以便于节约时间。

- 各个线程摘完之后汇总计算总苹果树。

-

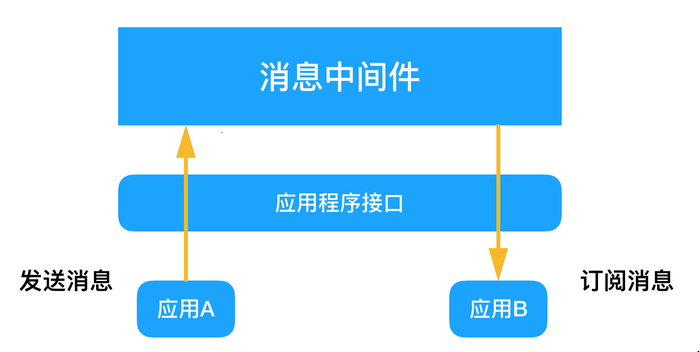

actor模型 每个人都有明确分工,这就是Actor模式。每个线程都是一个Actor,这些Actor不共享任何内存,所有的数据都是通过消息传递的方式进行的。-

actor模型属于一种基于消息传递机制并行任务处理思想,actor之间不共享任何内存它, 以消息的形式来进行线程间数据传输,进而避免了数据同步错误的隐患。 -

actor在接受到消息之后可以自己进行处理,也可以继续传递(分发)给其它actor进行处理。 - 在使用

actor模型的时候需要使用第三方Akka提供的框架。

-

-

生产者消费者模型

- 生产者消费者模型都比较熟悉,其核心是使用一个缓存来保存任务。

- 开启

一个/多个线程来生产任务,然后再开启一个/多个线程来从缓存中取出任务进行处理。 - 这样的好处是任务的生成和处理分隔开

- 生产者不需要处理任务,只负责向生成任务然后保存到缓存。

- 而消费者只需要从缓存中取出任务进行处理。

- 使用的时候可以根据任务的生成情况和处理情况开启不同的线程来处理。比如,生成的任务速度较快,那么就可以灵活的多开启几个消费者线程进行处理,这样就可以避免任务的处理响应缓慢的问题。

-

master-worker模型-

master-worker模型类似于任务分发策略,开启一个master线程接收任务,然后在master中根据任务的具体情况进行分发给其它worker子线程,然后由子线程处理任务。 - 如需返回结果,则

worker处理结束之后把处理结果返回给master。

-

4.18 请你来说一说协程

- 概念:

- 协程,又称微线程,纤程,英文名

Coroutine。 - 协程看上去也是子程序,但执行过程中,在子程序内部可中断,然后转而执行别的子程序,在适当的时候再返回来接着执行。

- 例如:

def A() : print '1' print '2' print '3' def B() : print 'x' print 'y' print 'z' - 由协程运行结果可能是

12x3yz。在执行A的过程中,可以随时中断,去执行B,B也可能在执行过程中中断再去执行A。 - 但协程的特点在于是一个线程执行。

- 协程,又称微线程,纤程,英文名

- 协程和线程区别:

->进程、线程和协程的理解- 那和多线程比,协程最大的优势就是协程极高的执行效率。

- 因为子程序切换不是线程切换,而是由程序自身控制,因此,没有线程切换的开销,和多线程比,线程数量越多,协程的性能优势就越明显。

- 第二大优势就是不需要多线程的锁机制,因为只有一个线程,也不存在同时写变量冲突,在协程中控制共享资源不加锁,只需要判断状态就好了,所以执行效率比多线程高很多。

- 其他

- 在协程上利用

多核CPU呢——多进程+协程,既充分利用多核,又充分发挥协程的高效率,可获得极高的性能。 -

Python对协程的支持还非常有限,用在generator中的yield可以一定程度上实现协程。虽然支持不完全,但已经可以发挥相当大的威力了。

- 在协程上利用

4.19 用户态到内核态的转化原理

-

用户态切换到内核态的

3种方式- 系统调用

- 这是用户进程主动要求切换到内核态的一种方式,用户进程通过系统调用申请操作系统提供的服务程序完成工作。

- 而系统调用的机制其核心还是使用了操作系统为用户特别开放的一个中断来实现,例如

Linux的ine 80h中断。

- 异常

- 当

CPU在执行运行在用户态的程序时,发现了某些事件不可知的异常,这是会触发由当前运行进程切换到处理此异常的内核相关程序中,也就到了内核态,比如缺页异常。

- 当

- 外围设备的中断

- 当外围设备完成用户请求的操作之后,会向

CPU发出相应的中断信号,这时CPU会暂停执行下一条将要执行的指令,转而去执行中断信号的处理程序,如果先执行的指令是用户态下的程序,那么这个转换的过程自然也就发生了有用户态到内核态的切换。 - 比如硬盘读写操作完成,系统会切换到硬盘读写的中断处理程序中执行后续操作等。

- 当外围设备完成用户请求的操作之后,会向

- 系统调用

- 切换操作

- 从触发方式看,可以在认为存在前述3种不同的类型,但是从最终实际完成由用户态到内核态的切换操作上来说,涉及的关键步骤是完全一样的,没有任何区别,都相当于执行了一个中断响应的过程,因为系统调用实际上最终是中断机制实现的,而异常和中断处理机制基本上是一样的

- 用户态切换到内核态的步骤主要包括:

1) 从当前进程的描述符中提取其内核栈的

ss0及esp0信息。 2) 使用ss0和esp0指向的内核栈将当前进程的cs,eip,eflags,ss,esp信息保存起来,这个过程也完成了由用户栈找到内核栈的切换过程,同时保存了被暂停执行的程序的下一条指令。 3) 将先前由中断向量检索得到的中断处理程序的cs,eip信息装入相应的寄存器,开始执行中断处理程序,这时就转到了内核态的程序执行了。

4.20 微内核与宏内核

- 宏内核:

- 除了最基本的进程、线程管理、内存管理外,将文件系统,驱动,网络协议等等都集成在内核里面,例如

linux内核。 - 优点:效率高。

- 缺点:稳定性差,开发过程中的

bug经常会导致整个系统挂掉。

- 除了最基本的进程、线程管理、内存管理外,将文件系统,驱动,网络协议等等都集成在内核里面,例如

- 微内核:

- 内核中只有最基本的调度、内存管理。驱动、文件系统等都是用户态的守护进程去实现的。

- 优点:稳定,驱动等的错误只会导致相应进程死掉,不会导致整个系统都崩溃。

- 缺点:效率低。典型代表

QNX,QNX的文件系统是跑在用户态的进程,称为resmgr的东西,是订阅发布机制,文件系统的错误只会导致这个守护进程挂掉。不过数据吞吐量就比较不乐观了。

4.21 介绍一下5种IO模型

- 参考:

-

阻塞IO:

- 调用者调用了某个函数,等待这个函数返回,期间什么也不做,不停的去检查这个函数有没有返回,必须等这个函数返回才能进行下一步动作

-

非阻塞IO:

- 非阻塞等待,每隔一段时间就去检测

IO事件是否就绪。没有就绪就可以做其他事。

- 非阻塞等待,每隔一段时间就去检测

-

信号驱动IO:

- 用户进程使用

sigaction函数对信号驱动IO安装一个信号处理函数, 继承继续执行, 当IO事件就绪,进程收到SIGIO信号。 -

linux用套接口进行信号驱动IO,安装一个信号处理函数,进程继续运行并不阻塞,当IO事件就绪,进程收到SIGIO信号。 - 然后处理

IO事件。(数据从内核空间拷贝到用户空间是线程干的, 此期间线程阻塞)

- 用户进程使用

-

异步IO:

-

linux中可以调用aio_read函数告诉内核描述字缓冲区指针和缓冲区的大小、文件偏移及通知的方式,然后立即返回 - 当内核将数据拷贝到缓冲区后,再通知应用程序。(数据从内核空间拷贝至用户空间,是内核干的, 此期间线程不阻塞, 通知的方式也是调用的时候指定的)

-

-

IO复用/多路转接IO:

-

linux用select/poll函数实现IO复用模型,这两个函数也会使进程阻塞,但是和阻塞IO所不同的是这两个函数可以同时阻塞多个IO操作。 - 而且可以同时对多个读操作、写操作的

IO函数进行检测。 - 知道有数据可读或可写时,才真正调用

IO操作函数4.21

server端监听端口,但还没有客户端连接进来,此时进程处于什么状态?

-

- 如果是

阻塞io则处于阻塞状态 - 如果是

select, poll, epoll方式的io复用则是循环等待状态

4.22 进程和作业的区别?

- 进程是程序的一次动态执行,属于动态概念;

- 一个进程可以执行一个或几个程序,同一个程序可由几个进程执行;

- 程序可以作为一种软件资源长期保留,而进程是程序的一次执行;

- 进程具有并发性,能与其他进程并发执行;

- 进程是一个独立的运行单位;

- 进程:进程是一个程序对某个数据集的执行过程,是分配资源的基本单位。

- 作业:作业是用户需要计算机完成的某项任务,是要求计算机所做工作的集合

- 区别:

- 作业的调度属于高级调度,进程的调度属于低级调度

- 作业就是从外存放到内存的一个过程,它可以包含一个或多进程。

- 参考: 作业与进程的区别

4.23 守护进程是什么?怎么实现?

- 守护进程

(Daemon)是运行在后台的一种特殊进程。它独立于控制终端并且周期性地执行某种任务或等待处理某些发生的事件。守护进程是一种很有用的进程。 - 守护进程特点

- 守护进程最重要的特性是后台运行。

- 守护进程必须与其运行前的环境隔离开来。这些环境包括未关闭的文件描述符,控制终端,会话和进程组,工作目录以及文件创建掩模等。这些环境通常是守护进程从执行它的父进程(特别是

shell)中继承下来的。 - 守护进程的启动方式有其特殊之处。

- 它可以在

Linux系统启动时从启动脚本/etc/rc.d中启动 - 可以由作业规划进程

crond启动 - 还可以由用户终端

(shell)执行。

- 它可以在

- 实现

- 1) 在父进程中执行

fork并exit推出;- 如果该守护进程是作为一个简单的shell命令启动的,那么终端关闭,则该进程就会结束,这样符合守护进程能在后台不断运行的特点;

- 子进程继承了父进程的进程组id,但具有了一个新的进程id, 这保证了子进程不是一个进程组的组长进程,这个是下面调用setsid()的必要前提条件。

- 2) 在子进程中调用

setsid函数创建新的会话;使调用进程:- 成为新会话的首进程

- 成为一个新进程组的组长进程

- 没有控制终端

- 3) 在子进程中调用

chdir函数,让根目录/成为子进程的工作目录; - 4) 在子进程中调用

umask函数,设置进程的umask为0;将文件模式创建屏蔽字设置为0,由继承得来的文件模式创建屏蔽字可能会拒绝设置某些权限;例如,若守护进程要创建一个组可读可写的文件,而继承来的文件模式创建屏蔽字可能屏蔽了这两种权限,于是守护进程所要求的组可读可写就不起作用 - 5) 在子进程中关闭任何不需要的文件描述符;这使守护进程不在持有从父进程继承来的文件描述符。可以通过getdtablesize()函数来获得全部描述符的个数。

4.24 线程和进程的区别;共享资源的区别

- 1) 在父进程中执行

进程还有所谓进程默认堆,用户也可以创建自己的堆。

- 线程私有:线程栈,寄存器,程序寄存器

- 共享:堆,地址空间,全局变量,静态变量

- 进程私有:地址空间,堆,全局变量,栈,寄存器

- 共享:代码段,公共数据,进程目录,进程ID

4.25 递归锁?

- 线程同步能够保证多个线程安全访问竞争资源,最简单的同步机制是引入互斥锁。

- 互斥锁为资源引入一个状态:

锁定/非锁定。 - 某个线程要更改共享数据时,先将其锁定,此时资源的状态为“锁定”,其他线程不能更改;直到该线程释放资源,将资源的状态变成“非锁定”,其他的线程才能再次锁定该资源。

- 互斥锁保证了每次只有一个线程进行写入操作,从而保证了多线程情况下数据的正确性。

- 互斥锁为资源引入一个状态:

- 读写锁从广义的逻辑上讲,也可以认为是一种共享版的互斥锁。如果对一个临界区大部分是读操作而只有少量的写操作,读写锁在一定程度上能够降低线程互斥产生的代价。

-

Mutex可以分为递归锁(recursive mutex)和非递归锁(non-recursive mutex)。- 可递归锁也可称为可重入锁

(reentrant mutex),非递归锁又叫不可重入锁(non-reentrantmutex)。 - 二者唯一的区别是,同一个线程可以多次获取同一个递归锁,不会产生死锁。

- 而如果一个线程多次获取同一个非递归锁,则会产生死锁。

- 可递归锁也可称为可重入锁

4.26 执行一个系统调用时,OS发生的过程,越详细越好

- 执行用户程序(如:

fork) - 根据

glibc中的函数实现,取得系统调用号并执行int$0x80产生中断。 - 进行地址空间的转换和堆栈的切换,执行

SAVE_ALL。(进行内核模式) - 进行中断处理,根据系统调用表调用内核函数。

- 执行内核函数。

- 执行

RESTORE_ALL并返回用户模式

4.27 IO 复用的原理?零拷贝?三个函数?epoll 的LT 和ET 模式的理解。

-

IO复用是Linux中的IO模型之一,IO复用就是进程预先告诉内核需要监视的IO条件,使得内核一旦发现进程指定的一个或多个IO条件就绪,就通过进程进程处理,从而不会在单个IO上阻塞了。Linux中,提供了select、poll、epoll三种接口函数来实现IO复用。 Select-

select的缺点:- 1 单个进程能够监视的文件描述符的数量存在最大限制,通常是

1024。由于select采用轮询的方式扫描文件描述符,文件描述符数量越多,性能越差; - 2 内核

/用户空间内存拷贝问题,select需要大量句柄数据结构,产生巨大开销; - 3

Select返回的是含有整个句柄的数组,应用程序需要遍历整个数组才能发现哪些句柄发生事件; - 4

Select的触发方式是水平触发,应用程序如果没有完成对一个已经就绪的文件描述符进行IO操作,那么每次select调用还会将这些文件描述符通知进程。

- 1 单个进程能够监视的文件描述符的数量存在最大限制,通常是

-

Poll- 与select 相比,poll 使用链表保存文件描述符,一你才没有了监视文件数量的限制,但其他三个缺点依然存在

- Epoll

- 上面所说的select 缺点在epoll 上不复存在,epoll 使用一个文件描述符管理多个描述符,将用户关系的文件描述符的事件存放到内核的一个事件表中,这样在用户空间和内核空间的copy 只需一次。Epoll 是事件触发的,不是轮询查询的。没有最大的并发连接限制,内存拷贝,利用mmap()文件映射内存加速与内核空间的消息传递。 区别总结:

- 支持一个进程所能打开的最大连接数

- 1 Select 最大1024 个连接,最大连接数有FD_SETSIZE 宏定义,其大小是32 位整数表示,可以改变宏定义进行修改,可以重新编译内核,性能可能会影响;

- 2 Poll 没有最大连接限制,原因是它是基于链表来存储的;

- 3 连接数限数有上限,但是很大;

- FD 剧增后带来的IO 效率问题

- 1 因为每次进行线性遍历,所以随着FD 的增加会造成遍历速度下降,效率降低;

- 2 Poll 同上;

- 3 因为epool 内核中实现是根据每个fd 上的callback 函数来实现的,只有活跃的socket 才会主动调用callback,所以在活跃socket 较少的情况下,使用epoll没有前面两者的现象下降的性能问题。

- 消息传递方式

- 1 Select 内核需要将消息传递到用户空间,都需要内核拷贝;

- 2 Poll 同上;

- 3 Epoll 通过内核和用户空间共享来实现的。

- epoll 的LT 和ET 模式的理解:

- epoll 对文件描述符的操作有两种模式:LT(level trigger)和ET(edge trigger),LT是默认模式。

- 区别:

- LT 模式:当epoll_wait 检测到描述符事件发生并将此事件通知应用程序,应用程序可以不立即处理该事件。下次调用epoll_wait 时,会再次响应应用程序并通知此事件。

- ET 模式:当epoll_wait 检测到描述符事件发生并将此事件通知应用程序,应用程序必须立即处理该事件。如果不处理,下次调用epoll_wait 时,不会再次响应应用程序并通知此事件。

4.28 Linux 是如何避免内存碎片的

- 在固定式分区分配中, 为将一个用户作业装入内存, 内存分配程序从系统分区表中找出一个能满足作业要求的空闲分区分配给作业, 由于一个作业的大小并不一定与分区大小相等, 因此, 分区中有一部分存储空间浪费掉了. 由此可知, 固定式分区分配中存在内碎片.

- 在可变式分区分配中, 为把一个作业装入内存, 应按照一定的分配算法从系统中找出一个能满足作业需求的空闲分区分配给作业, 如果这个空闲分区的容量比作业申请的空间容量要大, 则将该分区一分为二, 一部分分配给作业, 剩下的部分仍然留作系统的空闲分区。由此可知,可变式分区分配中存在外碎片.

- 伙伴系统

-

据可移动性组织页避免内存碎片

- 参考:Linux是如何避免内存碎片的

- 这里先对

Linux内存管理做一个简单介绍-

linux kernel通过把整个物理内存划分成以一个个page进行管理,管理器就是伙伴系统,它的最小分配单元就是page。 - 但是对于小于

page的内存分配,如果直接分配一个page,是一个很大的浪费。 -

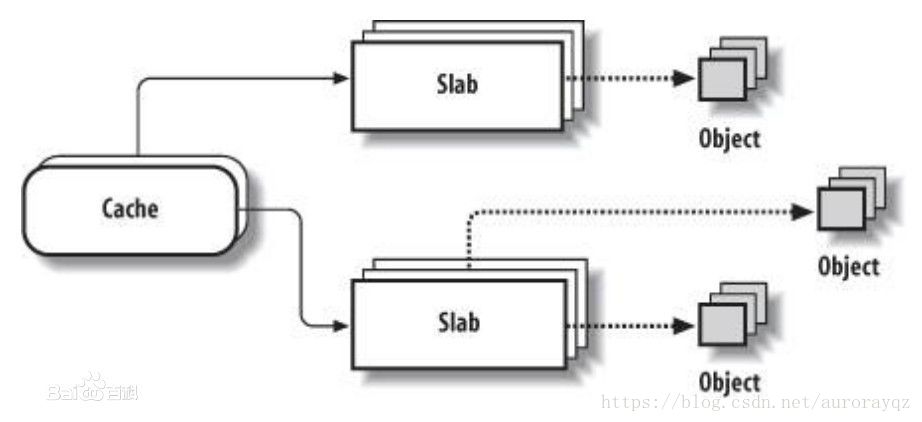

linux kernel通过slab来实现对小于page大小的内存分配。-

slab把page按2的m次幂进行划分一个个字节块,当kmalloc申请内存时,通过slab管理器返回需要满足申请大小的最小空闲内存块。 -

slub主要是针对slab的对象管理数据的优化版本,相比于slab,slub提供更小的管理成本开销。而且slub对多核系统的支持也更加友好。

-

-

- 所以

kernel的内存管理是个2层分层系统,从下往上依次为:- 第一层为全部物理内存:其管理器为伙伴系统,最小管理单位为

page; - 第二层为

slab page:其管理器为slab/slub,最小管理单位为2的m次幂的字节块;

- 第一层为全部物理内存:其管理器为伙伴系统,最小管理单位为

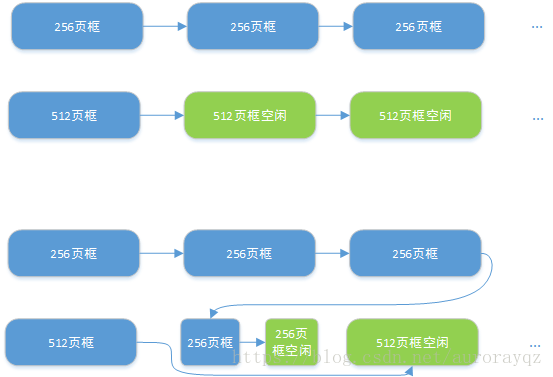

- 伙伴系统(

buddy system)-

Linux采用著名的伙伴系统(buddy system)算法来解决外碎片问题。把所有的空闲页框分组为11个块链表,每个链表分别包含大小为1,2,4,8,16,32,64,128,256,512,1024个连续的页框,对1024个页框的最大请求对应着4MB大小的连续RAM(每页大小为4KB),每个块的第一个页框的物理地址是该块大小的整数倍,例如,大小为16个页框的块,其起始地址是16*2^12的倍数。 - 我们通过一个例子来说明伙伴算法的工作原理,假设现在要请求一个

256个页框的块(1MB),算法步骤如下:- 在

256个页框的链表中检查是否有一个空闲快,- 如果有,请求满足。

- 如果没有,查找下一个更大的块,

- 在

512个页框的链表中检查是否有一个空闲块,- 如果有,把

512个页框的空闲块分为两份,第一份用于满足请求,第二份链接到256个页框的链表中。 - 如果没有空闲块,继续寻找下一个更大的块。

- 如果有,把

- 在

- 下图比较形象地描述了该过程。

- 页的释放

- 以上过程的逆过程,就是页框块的释放过程,也是该算法名字的由来,内核试图把大小为

B的一对空闲伙伴块合并为一个2B的单独块,满足以下条件的两个块称之为伙伴: - 两个块具有相同的大小

- 他们的物理地址是连续的

- 第一块的第一个页框的物理地址是

2 * B * 2^12 - 该算法是递归的,如果它成功合并了

B,就会试图去合并2B,以再次试图形成更大的块

- 以上过程的逆过程,就是页框块的释放过程,也是该算法名字的由来,内核试图把大小为

-

- 高速缓存

Slab层-

slab是Linux操作系统的一种内存分配机制。其工作是针对一些经常分配并释放的对象,如进程描述符等,这些对象的大小一般比较小,如果直接采用伙伴系统来进行分配和释放,不仅会造成大量的内存碎片,而且处理速度也太慢。 -

slab分配器是基于对象进行管理的,相同类型的对象归为一类(如进程描述符就是一类),- 每当要申请这样一个对象,

slab分配器就从一个slab列表中分配一个这样大小的单元出去, - 而当要释放时,将其重新保存在该列表中,而不是直接返回给伙伴系统,从而避免这些内碎片。

- 每当要申请这样一个对象,

-

slab分配器并不丢弃已分配的对象,而是释放并把它们保存在内存中。当以后又要请求新的对象时,就可以从内存直接获取而不用重复初始化。 - 对象高速缓存的组织如下图所示,高速缓存的内存区被划分为多个

slab,每个slab由一个或多个连续的页框组成,这些页框中既包含已分配的对象,也包含空闲的对象。 - 在

cache和object中加入slab分配器,是在时间和空间上的折中方案。

-

4.29 Linux的内存空间的分配

32位操作系统

64位操作系统

4.30 Linux的子系统

- 内存管理

- 进程调度

- 网络子系统

- 进程间通信

- 虚拟文件系统

4.31 Linux 常用操作

-

ls命令,不仅可以查看linux文件包含的文件,而且可以查看文件权限; -

cd命令,切换当前目录到dirName -

pwd命令,查看当前工作目录路径; -

mkdir命令,创建文件夹 -

rm命令,删除一个目录中的一个或多个文件或目录 -

rmdir命令,从一个目录中删除一个或多个子目录项, -

mv命令,移动文件或修改文件名 -

cp命令,将源文件复制至目标文件,或将多个源文件复制至目标目录 -

cat命令,显示文件内容; -

touch命令,创建一个文件 -

vim命令, -

which命令查看可执行文件的位置,whereis查看文件的位置,find实际搜寻硬盘查询文件名称; -

chmod命令,用于改变linux系统文件或目录的访问权限,421,ewr -

tar命令,用来压缩和解压文件。tar本身不具有压缩功能,只具有打包功能,有关压缩及解压是调用其它的功能来完成。 -

chown命令,将指定文件的拥有者改为指定的用户或组,用户可以是用户名或者用户ID; -

ln命令; -

grep命令,强大的文本搜索命令,grep全局正则表达式搜素; -

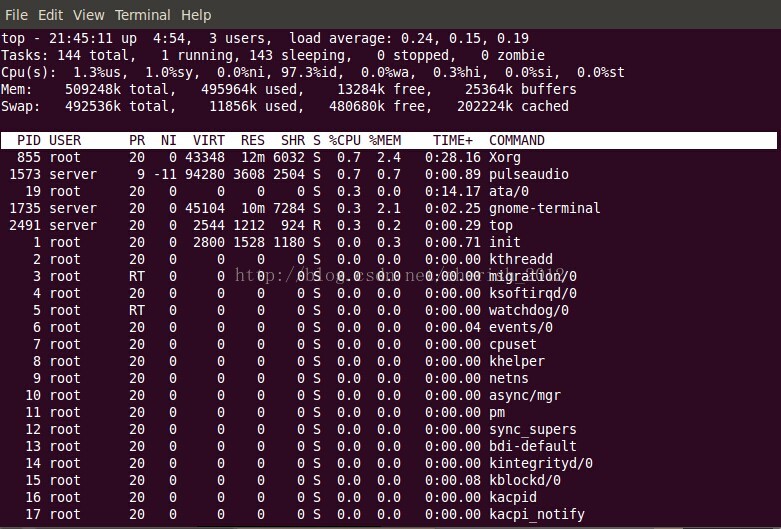

ps命令,用来查看当前运行的进程状态,一次性查看,如果需要动态连续结果使用top; -

top命令,显示当前系统正在执行的进程的相关信息,包括进程ID、内存占用率、CPU占用率等; -

kill命令,发送指定的信号到相应进程。不指定型号将发送SIGTERM(15)终止指定进程。 -

netstat:用于显示各种网络相关信息 -

tcpdump:截获本及网络接口的数据 -

ipcs:检查系统上共享内存的分配,报告进程间通信设施状态,包括当前活动消息队列、共享内存段、信号量、远程队列和本地队列标题. -

ipcrm:手动解除系统上共享内存的分配

4.32 linux内核中的Timer定时器机制

- 低精度时钟

-

Linux 2.6.16之前,内核只支持低精度时钟, - 内核定时器的工作方式:

- 系统启动后,会读取时钟源设备

(RTC, HPET,PIT…),初始化当前系统时间。 - 内核会根据

HZ(系统定时器频率,节拍率)参数值,设置时钟事件设备,启动tick(节拍)中断。 -

HZ表示1秒内产生时钟硬件中断的个数,tick就表示连续两个中断的间隔时间。 - 设置时钟事件设备后,时钟事件设备会定时产生一个

tick中断,触发时钟 中断处理函数,更新系统时钟,并检测timer wheel,进行超时事件的处理。

- 系统启动后,会读取时钟源设备

- 在上面工作方式下,

Linux 2.6.16之前,内核软件定时器采用timer wheel多级时间轮的实现机制,维护操作系统的所有定时事件。timer wheel的触发是基于系统tick周期性中断。 - 所以说这之前,

linux只能支持ms级别的时钟,随着时钟源硬件设备的精度提高和软件高精度计时的需求,有了高精度时钟的内核设计。

-

- 高精度时钟

-

Linux 2.6.16,内核支持了高精度的时钟,内核采用新的定时器hrtimer, - 其实现逻辑和

Linux 2.6.16之前定时器逻辑区别:-

hrtimer采用红黑树进行高精度定时器的管理,而不是时间轮; - 高精度时钟定时器不在依赖系统的

tick中断,而是基于事件触发。 - 旧内核的定时器实现依赖于系统定时器硬件定期的

tick,基于该tick,内核会扫描timer wheel处理超时事件,会更新jiffies,wall time(墙上时间,现实时间),process的使用时间等等工作。 - 新的内核不再会直接支持周期性的

tick,新内核定时器框架采用了基于事件触发,而不是以前的周期性触发。新内核实现了hrtimer(high resolution timer):于事件触发。

-

-

hrtimer的工作原理:- 通过 将高精度时钟硬件的下次中断触发时间设置为红黑树中最早到期的

Timer的时间 ,时钟到期后从红黑树中得到下一个Timer的到期时间,并设置硬件,如此循环反复。 - 在高精度时钟模式下,操作系统内核仍然需要周期性的

tick中断,以便刷新内核的一些任务。hrtimer是基于事件的,不会周期性出发tick中断,所以为了实现周期性的tick中断(dynamic tick):- 系统创建了一个模拟

tick时钟的特殊hrtimer,- 将其超时时间设置为一个

tick时长,在超时回来后,完成对应的工作, - 然后再次设置下一个

tick的超时时间,以此达到周期性tick中断的需求。

- 将其超时时间设置为一个

- 引入了

dynamic tick,是为了能够在使用高精度时钟的同时节约能源,这样会产生tickless情况下,会跳过一些tick。

- 系统创建了一个模拟

- 新内核对相关的时间硬件设备进行了统一的封装,定义了主要有下面两个结构:

-

时钟源设备(closk source device):抽象那些能够提供计时功能的系统硬件,比如RTC(Real Time Clock)、TSC(Time Stamp Counter),HPET,ACPIPM-Timer,PIT等。不同时钟源提供的精度不一样,现在PC大都是支持高精度模式(high-resolution mode)也支持低精度模式(low-resolution mode)。 -

时钟事件设备(clock event device):系统中可以触发one-shot(单次)或者周期性中断的设备都可以作为时钟事件设备。

-

- 通过 将高精度时钟硬件的下次中断触发时间设置为红黑树中最早到期的

- 当前内核同时存在新旧

timer wheel和hrtimer两套timer的实现,内核启动后会进行从低精度模式到高精度时钟模式的切换,hrtimer模拟的tick中断将驱动传统的低精度定时器系统(基于时间轮)和内核进程调度。4.33 进程

-

- 进程是程序的一次执行,该程序可以与其他程序并发执行;

- 进程有运行、阻塞、就绪三个基本状态;

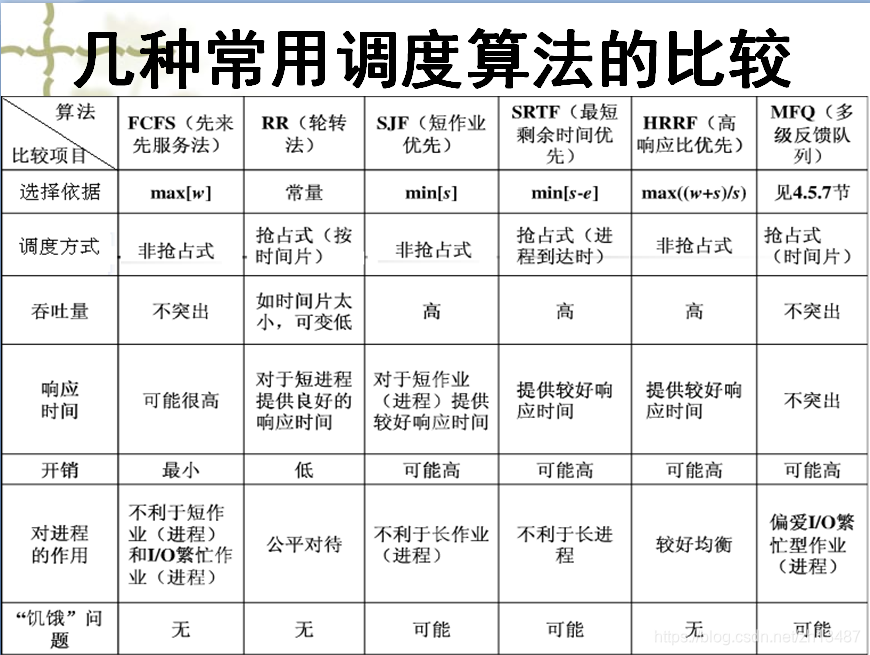

- 进程调度算法:先来先服务调度算法、短作业优先调度算法、非抢占式优先级调度算法、

- 抢占式优先级调度算法、高响应比优先调度算法、时间片轮转法调度算法;

4.34 Linux中的常见信号

linux下有哪些信号?

- 参考: SIGINT、SIGQUIT、 SIGTERM、SIGSTOP区别

- Linux下常用的信号有哪些;

- linux 信号量之SIGNAL 0(转)

- 常见信号:可以使用

kill -l查看存在的信号。 - 注意:编号为1 ~ 31的信号为传统UNIX支持的信号,是不可靠信号(非实时的),编号为32 ~ 63的信号是后来扩充的,称做可靠信号(实时信号)。不可靠信号和可靠信号的区别在于前者不支持排队,可能会造成信号丢失,而后者不会。

| 信号英文名 | 编号 | 信号中文说明 |

|---|---|---|

| Cancel | 0 | 确认进程是否存在 |

| SIGHUP | 1 | 挂断控制终端或进程;该信号让进程立即关闭,然后重新读取配置文件后关闭。 |

| SIGINT (ctrl-c) | 2 | 终止进程 |

| SIGQUIT | 3 | 与SIGINT相似,终止进程并阐述dump文件 |

| SIGILL | 4 | 执行了非法指令. 通常是因为可执行文件本身出现错误, 或者试图执行数据段. 堆栈溢出时也有可能产生这个信号。 |

| SIGTRAP | 5 | 由断点指令或其它trap指令产生. 由debugger使用。 |

| SIGABRT | 6 | 调用abort函数生成的信号。 |

| SIGBUS | 7 | 非法地址, 包括内存地址对齐(alignment)出错。比如访问一个四个字长的整数, 但其地址不是4的倍数。它与SIGSEGV的区别在于后者是由于对合法存储地址的非法访问触发的(如访问不属于自己存储空间或只读存储空间)。 |

| SIGFPE | 8 | 在发生致命的算术运算错误时发出. 不仅包括浮点运算错误, 还包括溢出及除数为0等其它所有的算术的错误。 |

| SIGKILL | 9 | 强制终止进;本信号不能被阻塞、处理和忽略 |

| SIGUSR1/SIGUSR2 | 10/12 | 用户保留信号 |

| SIGPIPE | 13 | 管道破裂,通常在进程间通信产生 |

| SIGALERM | 14 | 时钟定时信号,计算的是实际的时间或者时钟时间,alarm函数使用该信号 |

| SIGTERM | 15 | 终止进程;kill命令的默认信号。有时如果进程已经发生问题,这个信号是无法终止的,我们才会尝试SIGKILL信号,也就是信号9 |

| SIGSTKFLT | 16 | |

| SIGCHLD | 17 | 子进程结束时,父进程会收到或者信号,用于处理僵尸进程;默认忽略该信号 |

| SIGCONT | 18 | 恢复进程执行,默认忽略该信号 |

| SIGSTOP | 19 | 停止进程的执行;该进程还未结束, 只是暂停执行. 本信号不能被阻塞, 处理或忽略 |

| SIGTSTP | 20 | 停止进程的运行, 但该信号可以被处理和忽略. 用户键入SUSP字符时(通常是Ctrl-Z)发出这个信号 |

| SIGTTIN | 21 | 当后台作业要从用户终端读数据时, 该作业中的所有进程会收到SIGTTIN信号. 缺省时这些进程会停止执行 |

| SIGTTOU | 22 | 类似于SIGTTIN, 但在写终端(或修改终端模式)时收到 |

| SIGURG | 23 | 有”紧急”数据或out-of-band数据到达socket时产生. |

| SIGXCPU | 24 | 超过CPU时间资源限制. 这个限制可以由getrlimit/setrlimit来读取/改变 |

| SIGXFSZ | 25 | 当进程企图扩大文件以至于超过文件大小资源限制。 |

| SIGVTALRM | 26 | 虚拟时钟信号. 类似于SIGALRM, 但是计算的是该进程占用的CPU时间. |

| SIGPROF | 27 | 类似于SIGALRM/SIGVTALRM, 但包括该进程用的CPU时间以及系统调用的时间. |

| SIGWINCH | 28 | 窗口大小改变时发出. |

| SIGIO | 29 | 文件描述符准备就绪, 可以开始进行输入/输出操作 |

| SIGPWR | 30 | Power failure |

| SIGSYS | 31 | 非法的系统调用。 |

- 信号的来源

- 非法内存

- 硬件故障

- 键盘

- 信号的处理方式:

- 默认:如果是系统默认的话,那就会终止这个进程

- 忽略:信号来了我们不处理,装作没看到 SIGKILL SIGSTOP 不能忽略

- 捕获并处理

- 信号和中断的区别

4.35 Linux 常用命令

-

如何查看系统负载:Linux 如何查看系统负载

-

top命令查看进程以及资源使用的情况-

-

参数解析

-

top 行

- 22:23:10-系统当前时间;up 80 days, 11:44-系统运行时间;

- 1 user 当前登录用户数量。

-

load average: 1.31, 1.33, 1.29系统平均负荷(Load),三个值,分别表示过去 1 分钟,5 分钟和 15 分钟的平均负荷。

-

Tasks:进程统计信息,分别是:

- 66 total 总计 66 个进程。

- 1 running 其中 1 个正在运行。

- 65 sleeping 65 个处于休眠。

- 0 stopped 0 个停止。

- 0 zombie 以及 0 个僵尸进程。

- CPU:CPU 使用情况的统计。分成了 8 个部分,他们相加后当然应该是 100% 啦。

-

100.0 us:(user) 用户消耗的 CPU 百分比。 -

0.0 sy:(system) 系统消耗的 CPU。 -

0.0 ni: nice 进程消耗的 CPU。 -

0.0 id:(idle) 空闲的 CPU。 -

0.0 wa:(waiting) 等待处理 I/O 操作的 CPU 资源。 -

0.0 hi:(Hardware IRQ)处理硬件交互的 CPU 资源。 -

0.0 si:(Software Interrupts)处理软件交互的 CPU 资源。 -

0.0 st:(Steal Time)如果当前处于虚拟系统(vm)中,此项表示由管理程序从此系统偷走拿去处理其他任务的 CPU 资源。

-

- Mem & Swap:这两行表示物理内存(RAM)及 swap 空间的使用情况。拿内存这一行来说,依次表示:

- 606704 total 总内存

- 89464 free 空闲的部分

- 128300 used 使用的部分

- 388940 buff/cache buff 或缓存的部分

- 进程列表:紧接着列出的是各进程,默认以 CPU 使用量排序

- PID: 进程的 id,通过它来操作指定进程。

- USER: 进程的所有者。

- PR: 进程的优先级。

- NI: 进程的 NICE 值,默认 0。

- VIRT: 进程使用的虚拟内存。

- RES: 进程使用的物理内存。

- SHR: 进程使用的共享内存。

- S: status,进程的状态: S=睡眠中/sleep R=支行中/running Z=僵尸进程/zombie (S)。

- %CPU: 进程消耗的 CPU 百分比。

- %MEM: 进程使用的 RAM 百分比。

- TIME+: 进程运行时长。

- COMMAND: 进程名。

- 66 total 总计 66 个进程。

-

-

- 查看网口状态:

-

/etc/init.d/network status或者service --status-all -

mii-tool:mii-tool主要是用于配置网卡工作模式的指令,同时也可以进行查询、监控等工作! -

ifconfig -a:ifconfig是linux中用于显示或配置网络设备(网络接口卡)的命令,英文全称是network interfaces configuring

-

- 查看当前开启的端口(Linux之查看端口使用情况):

-

netstat -anp | grep pid查看进行占用的端口好号 -

lsof -i:8000:查看指定的端口号 -

netstat -ntlp|-an:查看所有端口的使用情况,可以结合grep共同使用。 -

ps -ef |grep mysqld:查看进程占用的端口 -

nmap:端口扫描 -

netstat -nupl/-ntpl/-anp:显示UDP/TCP/系统端口使用情况。

-

- 查看内存状态:free

4.36 为什么页的大小是4KB

答:

- 因为当其为操作系统为32位时,只有为12刚好实现两级页表和段页式的地址映射;能够充分利用硬件资源。

- 能够让偏移量寻址所有的X位和地址值。其它大小不能做到性能最优。

- 如果每个页面大小时8KB,前面的段页号对应的位数P1+P2=19;每个页面能够存储的地址是(8K/4B)=2048个;用第二段寻址需要映射全部地址段则需要2048个地址段,则P2=11,此时P1=8;则第一级页表只能寻址2^8=256个entry;此时第一级页表就有2048-256=1792个entry不能使用,这是多大的资源浪费???!!!

- 对于64位操作系统页表大小可能不同,目前ARMv8 64位的Linux中,大内存情况下2M页是比较合理的,而且OS中对其支持很完美。

4.37 端口号的作用和意义

端口号的主要作用是表示一台计算机中的特定进程所提供的服务。网络中的计算机是通过IP地址来代表其身份的,它只能表示某台特定的计算机,但是一台计算机上可以同时提供很多个服务,如数据库服务、FTP服务、Web服务等,我们就通过端口号来区别相同计算机所提供的这些不同的服务,如常见的端口号21表示的是FTP服务,端口号23表示的是Telnet服务端口号25指的是SMTP服务等。端口号一般习惯为4位整数,在同一台计算机上端口号不能重复,否则,就会产生端口号冲突这样的例外

4.38 段页式内存的意义和原因

主要是为了利用和管理好计算机的内存资源;解决如下的问题:

- 地址空间不隔离:要求操作系统来,进行管理和隔离。因此有了虚拟地址。

- 程序运行时候的地址不确定:需要操作系统来进行分配和偏移,因此有了段式内存管理。毕竟硬件每次在同一个地址运行对资源极大的浪费。

- 内存使用率低下(为什么会有页):可以通过缺页中断,将一部分不立即使用的内存置换过来。如果时段式的很不好确定每次置换的大小;因为必定需要一段连续的内存。页式的就好了。分段和分页的区别在于粒度。

4.39 Linux中cache 和 buffer的区别:

- Linux 中内存buffer和cache的区别

- Cache:高速缓存,是位于CPU与主内存间的一种容量较小但速度很高的存储器。Cache又分为一级Cache(L1 Cache)和二级Cache(L2 Cache),L1 Cache集成在CPU内部,L2 Cache早期一般是焊在主板上,现在也都集成在CPU内部,常见的容量有256KB或512KB L2 Cache。

- Buffer:缓冲区,一个用于存储速度不同步的设备或优先级不同的设备之间传输数据的区域。通过缓冲区,可以使进程之间的相互等待变少,从而使从速度慢的设备读入数据时,速度快的设备的操作进程不发生间断。

- Free中的buffer和cache:(它们都是占用内存):

- buffer : 作为buffer cache的内存,是块设备的读写缓冲区

- cache: 作为page cache的内存, 文件系统的cache。如果 cache 的值很大,说明cache住的文件数很多。如果频繁访问到的文件都能被cache住,那么磁盘的读IO bi会非常小。

4.39 线程池的线程数量如何选择

一般说来,大家认为线程池的大小经验值应该这样设置:(其中N为CPU的个数)

- 如果是CPU密集型应用,则线程池大小设置为N+1

- 如果是IO密集型应用,则线程池大小设置为2N

- 最佳线程数目 = 每个线程处理速度* CPU数目=((线程等待时间+线程CPU时间)/线程CPU时间 )* CPU数目=(线程等待时间与线程CPU时间之比 + 1)* CPU数目

4.40 Socket通道进行读写时,为什么使用直接内存,用堆内存有什么坏处

因为从堆内向磁盘/网卡读写数据时,数据会被先复制到堆外内存,然后堆外内存的数据被拷贝到硬件,如下图所示,直接写入堆外内存可避免堆内到堆外的一次数据拷贝。

- 堆外内存的优缺点

- 优点: 提升了IO效率(减少了从堆内到堆外的数据拷贝);减小了GC压力(不参与GC,有特定的回收机制);

- 缺点: 分配和回收堆外内存比较耗时;(解决方案:通过对象池避免频繁地创建和销毁堆外内存)

4.41 进程调度算法,讲一下

- 【面经笔记】进程调度方式;几种常见的调度算法

- 基于优先级调度:优先级高的进程先运行,可剥夺

- 基于调度策略:

- 先进先出(FCFS、FIFO):改进:将优先级与队列结合,每个优先级一个队列

- 轮询/轮转:周期性间隔产生中断,中断发生时,当前运行的进程置于就绪队列中,然后基于FIFO策略选择下一个就绪进程。

- 最短进程优先(Shortest Process Next,SPN):这是一个非抢占策略,下一次选择预计处理时间最短的进程进行处理,其难点是不知道进程的运行时间。风险是长进程饥饿。

- 最短剩余时间(Shortest Remaining Time ,SRT):针对SPN增加了抢占机制,总是选择预计剩余处理时间最短的进程。当一个新进程加入就绪队列时,它可能比当前运行的进程具有更短的剩余时间,因此,只要新进程就绪,就抢占当前正在运行的进程。 相对于一个正在运行的长作业,短作业可以立即被选择运行。

- 最高响应比:R=(W+S)/S;w 为等待处理器时间,s为预计的服务时间。处理器选择R最大的就绪进程。当系统偏向短作业时,长作业由于得不到服务的时间不断增加,R会不断增大,从而胜过短作业。

- 多级反馈队列调度:既能使高优先级的作业得到响应又能使短作业(进程)迅速完成。

- 由于没法获得进程剩余执行时间,那就关注已经执行的时间。多级反馈队列调度基于抢占原则(基于时间片),并使用动态优先级机制;当一个进程第一次进入系统后,优先级最高,随后的时间里,每当它被抢占时,它就被降级到下一个低优先级队列。除了优先级最低的队列外,其他队列都使用FIFO调度:每个队列都是基于时间片的轮询策略,但是每个进程在非底层队列中最多被调用一个时间片,然后就去了下一个队列。所以可以按FIFO调度理解。优先级最低的队列使用轮询调度,保证不会饿死。短进程很快会执行完,不会在就绪队列中降很多级,一个长进程会逐级下降。因此,新到的进程和短进程优先级优先于老进程和长进程。

4.42 linux常用命令,cat,awk,sort使用

-

sort:Linux sort命令用于将文本文件内容加以排序。sort可针对文本文件的内容,以行为单位来排序。-

sort [-bcdfimMnr][-o<输出文件>][-t<分隔字符>][+<起始栏位>-<结束栏位>][--help][--verison][文件]- -b 忽略每行前面开始出的空格字符。

- -c 检查文件是否已经按照顺序排序。

- -d 排序时,处理英文字母、数字及空格字符外,忽略其他的字符。

- -f 排序时,将小写字母视为大写字母。

- -i 排序时,除了040至176之间的ASCII字符外,忽略其他的字符。

- -m 将几个排序好的文件进行合并。

- -M 将前面3个字母依照月份的缩写进行排序。

- -n 依照数值的大小排序。

- -u 意味着是唯一的(unique),输出的结果是去完重了的。

- -o 将排序后的结果存入指定的文件。输出文件>

- -r 以相反的顺序来排序。

- -t 指定排序时所用的栏位分隔字符。分隔字符>

- +- 以指定的栏位来排序,范围由起始栏位到结束栏位的前一栏位。结束栏位>起始栏位>

- –help 显示帮助。

- –version 显示版本信息。

-

4.43 cpu使用率低负载率高的原因

- cpu使用率低负载高,原因分析

- 过低:等待磁盘I/O完成的进程过多,导致进程队列长度过大,但是cpu运行的进程却很少,这样就体现到负载过大了,cpu使用率低。

- 负载就是cpu在一段时间内正在处理以及等待cpu处理的进程数之和的统计信息,也就是cpu使用队列的长度统计信息,这个数字越小越好(如果超过CPU核心*0.7就是不正常)

- 事实证明,只有进程处于运行态(running)和不可中断状态(interruptible)才会被加入到负载等待进程中,也就是下面这两种情况的进程才会表现为负载的值。

- 即便需要立即使用CPU,也还需等待其他进程用完CPU。

- 即便需要继续处理,也必须等待磁盘输入输出完成才能进行。

- 负载总结为一句话就是:需要运行处理但又必须等待队列前的进程处理完成的进程个数。具体来说,也就是如下两种情况:

- 等待被授权予CPU运行权限的进程

- 等待磁盘I/O完成的进程

- 具体场景:

- 磁盘读写请求过多就会导致大量I/O等待

- MySQL中存在没有索引的语句或存在死锁等情况;造成循环等待或者全表扫描

- 外接硬盘故障,常见有挂了NFS,但是NFS server故障。

- 解决方法:

- 寻找最占CPU的进程

ps ux或者top -c - 寻找最耗CPU的线程;top -Hp 进程ID 显示一个进程ID的线程运行信息列表 (按键P按CPU占有资源排序)

- 将搜寻的结果进行分析和排查。

- 寻找最占CPU的进程

4.44 信号与信号量的区别:

-

信号与信号量的区别

- 信号:(signal)是一种处理异步事件的方式。信号是比较复杂的通信方式,用于通知接受进程有某种事件发生,除了用于进程外,还可以发送信号给进程本身。

- 信号量:(Semaphore)进程间通信处理同步互斥的机制。是在多线程环境下使用的一种设施, 它负责协调各个线程, 以保证它们能够正确、合理的使用公共资源。它的本质是计数器,信号量里面记录了临界资源的数目;进程对其访问都是原子操作(pv操作,p:占用资源,v:释放资源)

4.45 资源共享一定要用到锁吗?

不是必须的吧。锁主要还是对资源起到了一个保护的作用,前提时资源的进程独占性。如果仅仅是一个读资源,根本没必要加锁。而且线程间数据共享和同步的方式还有条件变量和临界区等手段。不一定使用锁。

4.46 内存屏障

内存屏障,其实就是禁止编译优化,防止指令乱序执行,使得代码指令有序。

4.47 代码中遇到进程阻塞,进程僵死,内存泄漏等情况怎么排查

- 主要还是通过ps查询状态,分析dump文件等方式排查

- 场景:xx.perl读取文件并发送邮件

- 现象:执行脚本的进程僵死(卡住)

- 解决

-

排查:ps -ef grep “perl xx.perl” 获取进程的pid编号 - 跟踪:strace -p 16634 (跟踪进程执行时的系统调用和所接收的信号(即它跟踪到一个进程产生的系统调用,包括参数、返回值、执行消耗的时间),卡在read(3,位置

- 进入/proc/pid/目录,执行ll,查看到3进行的是socket操作,也就是卡在通信。

-

netstat -anoutp grep 24432 查看通信的目标是什么:端口ip:25,可以确定是邮件服务器 - 可以使用pstack查询程序的栈跟踪;

pstack 11694

-

4.48 Linux大文件怎么查某一行的内容 && 搜索。

| cat info.log | grep ‘1711178968’ » temp.log |

4.49 Linux的cpu 100%怎么排查,top,jstack,日志,gui工具

- top -c(找到进程)

- top -Hp xxxxx(找到线程)

-

jstack 10765 grep xxxx(在堆栈里线程是16进制的)

4.50 僵死进程的处理

如果守护进程fork出自己的子进程,则有可能出现僵死进程。僵死进程的的特点是:先于父进程结束,而父进程没有wait()子进程的退出码。 因为每个子进程退出之前会留下一些数据结构,如果父进程没有处理的话,这些空间就浪费了。

- 僵尸进程的PID还占据着,意味着海量的子进程会占据满进程表项,会使后来的进程无法fork.

- 僵尸进程的内核栈无法被释放掉,为啥会留着它的内核栈,因为在栈的最低端,有着thread_info结构,它包含着 struct_task 结构,这里面包含着一些退出信息。

- 解决办法:

- wait和waitpid函数:父进程调用wait/waitpid等函数等待子进程结束,如果尚无子进程退出wait会导致父进程阻塞。waitpid可以通过传递WNOHANG使父进程不阻塞立即返回。

- sigaction信号处理函数(交给内核处理):如果父进程很忙可以用sigaction注册信号处理函数,在信号处理函数调用wait/waitpid等待子进程退出。(sigaction函数类似于signal函数,而且完全可以代替后者,也更稳定)

- signal忽略SIGCHLD信号(交给内核处理) :通过signal(SIGCHLD, SIG_IGN)通知内核对子进程的结束不关心,由内核回收。如果不想让父进程挂起,可以在父进程中加入一条语句:signal(SIGCHLD,SIG_IGN);表示父进程忽略SIGCHLD信号,该信号是子进程退出的时候向父进程发送的。常用于并发服务器的性能的一个技巧因为并发服务器常常fork很多子进程,子进程终结之后需要服务器进程去wait清理资源。如果将此信号的处理方式设为忽略,可让内核把僵尸子进程转交给init进程去处理,省去了大量僵尸进程占用系统资源

- fork两次:通过两次调用fork。父进程首先调用fork创建一个子进程然后waitpid等待子进程退出,子进程再fork一个孙进程后退出。这样子进程退出后会被父进程等待回收,而对于孙子进程其父进程已经退出所以孙进程成为一个孤儿进程,孤儿进程由init进程接管,孙进程结束后,init会等待回收。

4.51 Linux 中进程有哪几种状态?在 ps 显示出来的信息中,分别用什么符号表示的?

- 不可中断状态:进程处于睡眠状态,但是此刻进程是不可中断的。不可中断, 指进程不响应异步信号。

- 暂停状态/跟踪状态:向进程发送一个 SIGSTOP 信号,它就会因响应该信号 而进入 TASK_STOPPED 状态;当进程正在被跟踪时,它处于 TASK_TRACED 这个特殊的状态。正在被跟踪”指的是进程暂停下来,等待跟踪它的进程对它进行操作。

- 就绪状态:在 run_queue 队列里的状态

- 运行状态:在 run_queue 队列里的状态

- 可中断睡眠状态:处于这个状态的进程因为等待某某事件的发生(比如等待 socket 连接、等待信号量),而被挂起

- zombie 状态(僵尸):父亲没有通过 wait 系列的系统调用会顺便将子进程的尸体(task_struct)也释放掉

- 退出状态

5 计算机网络

5.1 epoll原理

- 参考:

- 调用顺序:

int epoll_create(int size);int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);int epoll_wait(int epfd, struct epoll_event *events,int maxevents, int timeout);

- 首先调用

epoll_create创建一个epoll描述符, 参数表示内核要监听描述符的数量, 调用成功将返回epoll描述符,失败时返回-1 - 然后使用

epoll_ctl对这个epoll描述符进行操作,把待监听的描述符添加进去, 这些监听描述符将会以epoll_event结构体的形式组成一颗红黑树 - 接着阻塞在

epoll_wait, 当存在监听的描述符就绪时,内核将会把其对应的结构体放入一个链表中,返回就绪事件的链表, 如果调用失败返回-1,超市返回0

5.1 路由器的功能?

- 路由选择与分组转发

5.2 ip 报文如何从下向上交付

- 详解IP、TCP报文头部及报文封装过程;

5.3 ip 地址有什么用,ip 地址和mac 地址, 为什么需要IP 地址

-

IP地址是在网络上分配给每台计算机或网络设备的32位数字标识。 - 在

Internet上, 每台计算机或网络设备的IP地址是全世界唯一的。 -

IP地址的格式是xxx.xxx.xxx.xxx,其中xxx是0到255之间的任意整数。例如,每步站主机的IP地址是219.134.132.131。 -

MAC地址是数据链路层的地址,如果mac地址不可直达,直接丢弃,在LAN里面,一个网卡的MAC地址是唯一的。 -

MAC地址在arp协议里常常用到,mac地址到ip地址的相互转化。 -

Mac地址是48位的地址。 -

IP地址是网络层的地址,如果ip地址不可达,接着转发,在WAN里面,ip地址不唯一,计算机的ip地址可以变动5.4 ARP 协议的作用

-

ARP(地址解析)协议是一种解析协议, - 当主机要发送一个

IP包的时候,会首先查一下自己的ARP高速缓存表(最近数据传递更新的IP-MAC地址对应表),如果查询的IP-MAC值对不存在, - 那么主机就向网络广播一个

ARP请求包,这个包里面就有待查询的IP地址, - 而直接收到这份广播的包的所有主机都会查询自己的

IP地址,如果收到广播包的某一个主机发现自己符合条件,那么就回应一个ARP应答包(将自己对应的IP-MAC对应地址发回主机), - 源主机拿到

ARP应答包后会更新自己的ARP缓存表。源主机根据新的ARP缓存表准备好数据链路层的的数据包发送工作。

5.6 RIP 路由协议

- 网络中的每一个路由器都要维护从它自己到其他每一个目标网络的距离记录;

- 距离也称为跳数,规定从一路由器到直接连接的网络跳数为

1,而每经过一个路由器,则距离加1; -

RIP认为好的路由就是它通过的路由器数量最少; -

RIP允许一条路径上最多有15个路由器,因为规定最大跳数为16; -

RIP默认每30秒广播一次RIP路由更新信息。 - 每一个路由表项目包括三个内容:

目的网络、距离、下一跳路由器 - 对地址为

X的路由器发过来的路由表,先修改此路由表中的所有项目:- 把下一跳字段中的地址改为

X,并把所有距离字段都加1。 - 对修改后的路由表中的每一个项目,进行以下步骤:

- 将

X的路由表(修改过的),与S的路由表的目的网络进行对比。若在X中出现,在S中没出现,则将X路由表中的这一条项目添加到S的路由表中。 - 对于目的网络在

S和X路由表中都有的项目进行下面步骤- 在

S的路由表中,若下一跳地址是x则直接用X路由表中这条项目替换S路由表中的项目。 - 在

S的路由表中,若下一跳地址不是x, 若X路由表项目中的距离d小于S路由表中的距离,则进行更新。

- 在

- 将

- 若

3分钟还没有收到相邻路由器的更新表,则把此相邻路由器记为不可到达路由器,即把距离设置为16。5.7 为什么使用IP 地址通信

- 把下一跳字段中的地址改为

- 由于全世界存在着各式各样的网络,它们使用不同的

硬件地址。要使这些异构网络能够互相通信就必须进行非常复杂的硬件地址转换工作,因此几乎是不可能的事。 - 连接到因特网的主机都拥有统一的

IP地址,它们之间的通信就像连接在同一个网络上那样简单方便,因为调用ARP来寻找某个路由器或主机的硬件地址都是由计算机软件自动进行的,对用户来说是看不见这种调用过程的。5.8 子网掩码有什么用?

- 子网掩码是一种用来指明一个

IP地址所标示的主机处于哪个子网中。 - 子网掩码不能单独存在,它必须结合

IP地址一起使用。 - 子网掩码只有一个作用,就是将某个